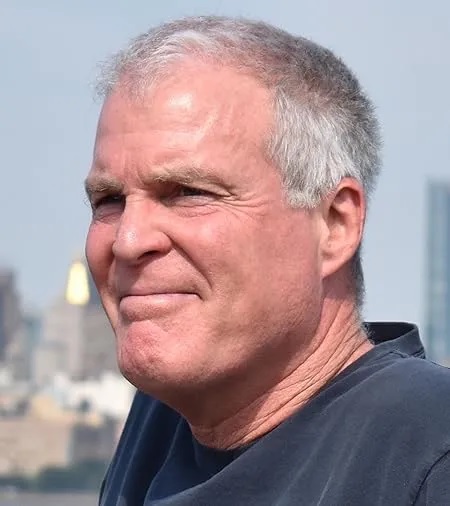

Les intervenants débattent de la « vérité et de la confiance » lors de « Synthetic Narratives ». De gauche à droite : la modératrice Camila Galaz, Emily Spratt, Avital Meshi, Christopher Meerdo et Fred Grinstein.

HOBOKEN, 30 OCTOBRE 2025. Une réunion dans mon université le week-end dernier m’a fait me sentir un peu mieux, presque malgré moi, à propos de l’intelligence artificielle.

Chris Manzione et Jonah King, artistes et professeurs d’art à l’Institut de technologie Stevens, ont organisé « SYNTHETIC NARRATIVE : AI / XR + THE FUTURE OF STORYTELLING ». XR désigne la réalité virtuelle et d’autres « technologies immersives ». Des artistes, technologues et penseurs s’y sont réunis pour explorer comment l’IA et la XR « transforment la manière dont nous créons, vivons et comprenons les histoires ».

Je m’assois au premier rang pour une session sur la « Vérité et la Confiance ». L’artiste Avital Meshi monte sur scène, portant sur son avant-bras droit un dispositif d’allure cyborg. L’appareil relie Meshi à ChatGPT, qui écoute ses conversations et, en réponse à ses sollicitations, lui dit quoi dire en lui soufflant des mots à l’oreille.

Meshi a expérimenté des ChatGPT sur mesure. L’un canalise le dramaturge Samuel Beckett, un autre ne prononce que des mots commençant par la lettre « a ». Meshi a porté ce dispositif pendant des mois d’affilée, une performance qu’elle appelle « GPT-ME ».

Ses collègues et amis se sentent mal à l’aise en interagissant avec elle, dit-elle, car ils ne savent pas s’ils parlent à elle ou à l’IA. Je comprends. À plusieurs reprises durant sa présentation, Meshi s’interrompt, attendant une réponse de son IA, et il y a quelque chose d’étrange dans ces silences.

Meshi avoue que, parfois elle ne sait plus où s’arrête son « vrai » moi et où commence son moi « artificiel ». Elle craint de devenir ce que le philosophe David Chalmers appelle un « zombie philosophique », qui paraît conscient, mais ne possède pas de vie intérieure.

Lorsque Meshi mentionne Chalmers, je donne un coup de coude à l’homme assis à ma droite : Chalmers.

Meshi dit qu’elle ne sait pas raconter de blagues en anglais, qui n’est pas sa langue maternelle, mais que peut-être ChatGPT le peut. Meshi interroge son appareil, attend, écoute, puis dit : Pour cette réunion, j’ai inventé un moi synthétique si convaincant que les ressources humaines m’ont dénoncée pour usurpation d’identité.

Quand le public rit, Meshi semble réellement ravie et surprise. Elle ne semble pas jouer, mais qui sait ? Peut-être même pas Meshi.

Vient ensuite Fred Grinstein, producteur de téléréalité, de documentaires et de contenus générés par IA, ayant travaillé pour A&E, Anonymous Content, HBO, Hulu, History et d’autres médias. Grinstein s’interroge : « Comment l’IA accélère notre relation défaillante avec la vérité ».

Tout le monde se concentre, à juste titre, sur la manière dont l’IA peut être utilisée pour diffuser de la désinformation, des deepfakes, des absurdités. Mais ces problèmes existent depuis les débuts de la photographie et du cinéma.

Et les contenus générés par IA peuvent, selon Grinstein, accroître notre conscience de leur potentiel de tromperie d’une manière saine et ludique. Il montre un clip de lapins bondissant sur un trampoline. Après avoir déduit que la vidéo était générée par IA, les spectateurs ont improvisé, débattu de ses qualités esthétiques, remplacé les lapins par d’autres animaux (chats, ours, rhinocéros).

L’IA peut renforcer le journalisme, ajoute Grinstein, de manière à servir la vérité. Il cite « Welcome to Chechnya », un documentaire de 2020 sur les personnes LGBTQ en Russie, qui protège l’anonymat des sources en les représentant par des avatars générés par IA.

La transparence est la clé pour gagner la confiance du public. Grinstein propose d’étiqueter les contenus assistés par IA avec des mentions similaires à celles indiquant les ingrédients des aliments. La blockchain peut aussi aider à établir la provenance des images.

Dans « L’IA comme médiumnité », l’historienne de l’art Emily Spratt parle des «?griefbots?» (robotchagrin ou chagrinbot), avatars des morts créés à partir de publications sur les réseaux sociaux et d’autres traces numériques. Ces griefbots, déjà devenus une entreprise commerciale, permettent aux endeuillés de communier avec les défunts.

Les vivants ont depuis longtemps cherché à communiquer avec les morts, dit Spratt. Elle projette un papyrus égyptien ancien sur lequel un fils se plaint à ses parents décédés de son héritage. Une autre diapositive montre un médium frauduleux qui, lors de séances, invoquait des « fantômes » faits de draps et de fil de fer. (En l’écoutant, je me souviens de mes frères et sœurs et moi faisions les imbéciles au Ouija quand nous étions enfants).

Spratt s’inquiète du fait que les simulations générées par IA des morts brouillent la frontière entre le sacré et le profane. À ce propos : une église de Lucerne, en Suisse, propose un Jésus IA multilingue avec lequel on peut discuter dans un confessionnal. Il y a un hic : si vous confessez vos péchés, rien ne garantit que le Christbot les gardera secrets. Drôle, inquiétant, blasphématoire ? À vous de voir.

L’artiste-chercheur Christopher Meerdo parle de « L’Archive hallucinante ». Meerdo produit des représentations d’archives générées par IA, dont l’une provient des ordinateurs d’Oussama ben Laden compilées par la CIA.

Meerdo propose de considérer les « hallucinations » de l’IA non pas simplement comme des « bogues épistémiques » ou des erreurs, mais comme potentiellement révélatrices. Les hallucinations peuvent révéler des structures profondes et des fissures dans nos « écosystèmes post-vérité ». (Oui, je me dis, comme les hallucinations psychédéliques.)

L’IA peut être utilisée comme arme ou comme outil, pour le mal ou pour le bien, dit Meerdo. Il espère que les artistes et autres créatifs apprendront à bidouiller l’IA et à l’utiliser à leurs propres fins. Sinon, le récit de l’IA sera dominé par « l’impérialisme et le fascisme ».

Chalmers conclut en parlant, eh bien, de toutes sortes de choses. De la technophilosophie, qui réfléchit aux implications de la technologie. De savoir si son Roomba a des « désirs ». De la définition du moi par son vieil ami Dan Dennett comme « centre de gravité narrative ». De la question de savoir si vous êtes l’autorité sur votre propre récit : que se passe-t-il si vous vous croyez saint, mais que les autres vous prennent pour un imbécile ? Du fait qu’au XVIIe siècle, John Locke avait anticipé l’intrigue de la série de science-fiction Severance, dont les personnages ont leur moi divisé en deux.

Le sujet principal de Chalmers est « À quoi parlons-nous lorsque nous parlons à des modèles de langage ». Il reçoit des courriels de gens convaincus que les chatbots sont conscients, sensibles, dotés d’émotions réelles. Le sont-ils ?

Chalmers doute que les IA actuelles possèdent une vie intérieure, mais il ne peut l’exclure. En 2017, il a coorganisé une conférence à l’Université de New York (à laquelle j’ai assisté) sur les esprits animaux. Des scientifiques y ont soutenu que les poissons et les insectes pourraient être conscients, alors pourquoi pas les modèles de langage ?

Les chatbots agissent certainement comme s’ils avaient des peurs, des désirs, des buts, dit Chalmers. Peut-être peut-on dire des modèles de langage, propose-t-il, qu’ils sont des quasi-personnes avec des quasi-moi et des quasi-désirs. Si vous demandez à un chatbot quel est son état mental, sa réponse peut sembler absurde, mais c’est aussi le cas de nombreux humains.

Et les IA évoluent rapidement, dit Chalmers, alors qui sait où elles en seront dans quelques années ? Chalmers conclut sur une note légèrement inquiétante : le fait que des « personnes » IA soient possibles, dit-il, ne signifie pas que nous devrions les créer.

L’essor continu de l’IA me terrifie encore, surtout parce que des singes arrogants en contrôlent le récit — sans parler du financement et de la mise en œuvre. Je crains que la frénésie autour de l’IA ne culmine dans un BOUM, le genre de catastrophe que William Gibson appelle « le gros lot ».

Mais je suis encouragé par la curiosité et la créativité excentriques manifestées à « Synthetic Narratives ». L’IA nous pousse à nous voir et à être nous-mêmes d’une manière nouvelle. C’est sûrement une bonne chose. Peut-être l’IA nous aidera-t-elle à traverser cette époque effrayante.

Et si les choses tournent vraiment mal, nous pourrons toujours demander à cyber-Jésus de nous sauver.

Texte original publié le 30 octobre 2025 : https://johnhorgan.org/cross-check/will-ai-save-us-from-ai