« Personne ne s’attend à ce qu’une simulation informatique d’un ouragan génère de véritables vents et de vraies pluies », écrit le neuroscientifique Anil Seth.

-

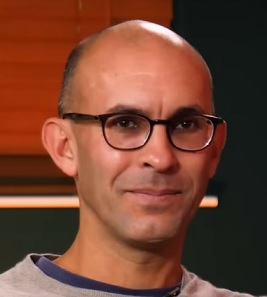

Le neuroscientifique Anil Seth expose trois raisons pour lesquelles les gens ont tendance à surestimer les chances que l’IA devienne consciente.

-

Personne ne sait ce qu’il faudrait pour construire une machine consciente — mais comme le souligne Seth, on ne peut pas l’exclure.

-

Étant donné les incertitudes, il met en garde contre toute tentative délibérée de créer une conscience artificielle.

Il y a quelques années, en 2022, l’ingénieur de Google Blake Lemoine a été licencié pour avoir affirmé que le chatbot sur lequel il travaillait était sensible. Il croyait qu’il pouvait ressentir des choses, potentiellement souffrir, et que le statut moral des grands modèles de langage (LLMs) devait être pris au sérieux. Il s’est avéré que c’est Lemoine qu’on n’a pas pris au sérieux.

Mais il y a quelques semaines, Kyle Fish — qui travaille comme « chercheur en bien-être de l’IA » chez Anthropic — a déclaré au New York Times qu’il y avait 15 % de chances que les chatbots soient déjà conscients. Qu’est-ce qui a changé ?

L’un des éléments est que les discussions sur la « conscience de l’IA » ont quitté les séminaires philosophiques (et les pubs) pour occuper le devant de la scène académique, et sont sorties de l’ombre dans l’industrie technologique. Cette transition, largement alimentée par les progrès stupéfiants des LLMs, est en un sens une bonne chose. Si nous finissions par créer des machines conscientes, volontairement ou non, nous déclencherions une crise morale sans précédent. Nous introduirions une nouvelle possibilité de souffrance dans le monde, en un clic de souris, et d’un type que nous ne reconnaîtrions peut-être même pas.

Je pense que les chances d’une véritable conscience artificielle — du moins selon les trajectoires actuelles de l’IA — sont bien plus faibles que ce que la plupart des gens croient (et certainement bien plus faibles que 15 %). Dans mon travail à l’interface des neurosciences et de l’IA, et dans mon livre Being You (tr fr Être Soi) j’expose trois raisons pour lesquelles nous avons tendance à surestimer la probabilité de machines sensibles.

La première réside dans notre propre constitution psychologique. Nous avons tendance à supposer que « intelligence » et « conscience » vont de pair, de sorte que quelque chose d’assez intelligent serait aussi conscient. Mais ce n’est pas parce que intelligence et conscience vont de pair en nous qu’elles vont de pair en général. Supposer qu’il en est ainsi reflète nos biais psychologiques, non une intuition de la réalité. Le langage exerce une attraction particulièrement forte sur ces biais, c’est pourquoi les gens se demandent si Claude d’Anthropic est conscient, mais pas AlphaFold de DeepMind, qui prédit le repliement des protéines.

La deuxième raison est aussi une hypothèse : en l’occurrence, que le cerveau biologique est une sorte d’ordinateur. Si le cerveau est vraiment un ordinateur fait de chair, alors tout ce qui dépend de son activité — qu’il s’agisse d’intelligence ou de conscience — devrait en principe être possible dans une version en silicium. Mais plus on examine le cerveau de près, moins il ressemble à un ordinateur. Il n’existe pas de séparation nette entre « logiciel mental (mindware)» et « matériel biologique (wetware) », comme il y en a entre matériel et logiciel dans nos appareils en silicium, et même un seul neurone est une usine biologique extrêmement complexe. La métaphore du cerveau-ordinateur n’a toujours été qu’une métaphore, et nous avons toujours des ennuis quand nous confondons une métaphore avec la chose elle-même. Si le cerveau n’est pas réellement un ordinateur, il y a beaucoup moins de raisons de penser que la conscience puisse apparaître dans une forme en silicium.

Pour le dire autrement : personne ne s’attend à ce qu’une simulation informatique d’un ouragan génère de véritables vents et de vraies pluies. De la même façon, un modèle informatique du cerveau pourrait ne jamais faire qu’un simulacre de conscience, sans jamais la faire émerger réellement.

La troisième raison est que nous sous-estimons d’autres explications possibles. Personne ne sait comment ni pourquoi la conscience apparaît, mais il existe bien d’autres possibilités que celle d’un algorithme d’un côté ou d’une magie immatérielle de l’autre. Une possibilité que j’explore dans mes recherches est que la conscience découle de notre nature d’êtres vivants : que c’est la vie, plutôt que le « traitement de l’information », qui insuffle une étincelle aux équations de la conscience.

L’éthique de tout cela est importante. Même si une véritable conscience artificielle est hors de portée avec les formes actuelles d’IA, les technologies « neuromorphiques » émergentes, de plus en plus semblables au cerveau, pourraient faire évoluer la situation. Même une IA qui ne fait que sembler consciente pose un problème éthique, même si, sous le capot, il n’y a qu’un vide subjectif. Une IA qui donne l’apparence de la conscience peut exploiter nos vulnérabilités psychologiques, fausser nos priorités morales, et — si nous traitons comme inertes des entités qui semblent ressentir (en ignorant peut-être leurs appels à l’aide) — nous risquons d’endurcir nos esprits.

Face à cette incertitude, que devons-nous faire ? D’abord, nous ne devrions pas chercher délibérément à créer une conscience artificielle. Même si nous ne savons pas ce qu’il faut pour créer une IA consciente, nous ne savons pas non plus comment écarter complètement cette possibilité. Ensuite, nous devrions distinguer avec soin les implications éthiques d’une IA qui serait réellement consciente de celles d’une IA qui semble irrésistiblement l’être. Les incertitudes existentielles de la première ne doivent pas nous détourner des dangers clairs et présents de la seconde.

Enfin, nous sommes confrontés à des incertitudes similaires dans de nombreux autres contextes : les personnes ayant subi des lésions cérébrales graves, les animaux non humains (des bactéries aux chauves-souris), les fœtus humains, et les nouvelles créations étranges en biologie synthétique, comme les « organoïdes cérébraux » (des cellules cérébrales en boîte qui s’interconnectent). Dans chaque cas, il y a des ambiguïtés quant à la présence de conscience, et dans chaque cas, nos décisions ont un poids moral. À mesure que la science, la technologie et la médecine progressent, davantage de ces scénarios passeront de la marge au premier plan. Ce qu’il nous faut, c’est rien de moins qu’une compréhension scientifique satisfaisante de la conscience elle-même.

Avis de transparence : Anil Seth est conseiller auprès de Conscium Ltd et AllJoined Inc.

Texte original publié le 14 mai 2025 : https://bigthink.com/neuropsych/the-illusion-of-conscious-ai/