Je crois que vos précédentes mises au point concluent une partie importante des thèmes traités durant notre conversation, mais qu’elles sont aussi un point de départ pour aborder une autre partie encore plus importante : celle relative à ce que vous proposez comme alternative à l’évolutionnisme. Vous ai-je bien compris ?

Tout à fait.

Vous avez affirmé que des positions comme celles des transformistes finalistes ne peuvent pas être considérées comme des explications scientifiques. En quoi consiste, alors, une explication scientifique ? Bien que vous y ayez fait allusion précédemment, il me semble qu’il serait bon d’approfondir cette idée.

Essayons d’aborder la question de manière claire et correcte. Nous pourrions partir de la notion de « paradigme scientifique », au sens que lui donne l’épistémologue américain Thomas Kuhn. Selon lui, la science ne peut pas se réduire à une simple recollection de données, c’est-à-dire à des descriptions et interprétations de phénomènes ; elle se manifeste spécifiquement lorsque ces données, et les théories qui les relient, trouvent place dans le cadre d’un certain « paradigme », donc dans une certaine Weltanschauung ou vision globale de la réalité (croyances, valeurs, techniques, etc.) existant sur un plan intuitif plus que sur un plan logique rigoureux. En d’autres termes, un paradigme repose sur un certain nombre de postulats, ou d’assertions non démontrées, dont la vérité est admise a priori ou comme allant de soi. Les vraies révolutions scientifiques se produisent précisément lorsqu’un paradigme sur le point d’épuiser toutes ses possibilités créatrices est remplacé par un autre paradigme, plus efficace et plus prometteur.

Le fait est que pendant plus d’un siècle la biologie s’est développée et a bâti ses théories dans le cadre, pour l’essentiel, du paradigme évolutionniste [1], qui fut défini avec clarté, pour la première fois, dans la Philosophie zoologique (1809) de Jean-Baptiste Monet de Lamarck. Il remplaça progressivement le paradigme organiciste, hérité d’Aristote et de Linné, qui voyait la nature comme un ensemble de forces bien distinctes, mais étroitement interdépendantes au sein d’un « Système Naturel » unitaire et harmonieux, et donc, dans la réalité, impossibles à séparer nettement les unes des autres : système qui était réputé stable et inchangé depuis l’origine des temps (n’oublions pas qu’à l’époque de Linné, on en était encore à l’aube des études paléontologiques).

Comme cela ressort de l’œuvre de Lamarck, le paradigme évolutionniste implique une triple croyance, postulée a priori sans être démontrée, à savoir :

1) que la vie est apparue à la surface de notre planète par génération spontanée et sous la forme de micro-organismes ;

2) que ces micro-organismes se sont multipliés de plus en plus, se regroupant ensuite dans des colonies et constituant progressivement, avec l’écoulement du temps géologique, des structures pluricellulaires de plus en plus complexes et diversifiées, jusqu’à former l’ensemble biologique actuel (homme compris) ;

3) que dans la naissance de la vie et dans son processus postérieur de transformation n’entrent pas en jeu des causes surnaturelles, mais des lois purement naturelles, donc susceptibles d’être découvertes et décrites sous une forme rigoureuse par la méthode scientifique.

Tels sont les grands traits du paradigme évolutionniste. Il faut souligner que Lamarck n’était pas athée, mais plutôt déiste à la mode des Lumières. Il estimait donc que le monde avait été créé par Dieu, mais qu’à partir du moment de la création il avait procédé pour son propre compte et en fonction, exclusivement, de ses lois propres, qui ne devaient rien au hasard et étaient donc rigoureusement déterministes. Lamarck proposa aussi une théorie pour expliquer les modalités du processus d’évolution. Selon lui, les organismes s’adaptaient au milieu « par nécessité », et cette action d’adaptation comportait la formation et le développement de nouveaux organes au détriment d’autres organes, qui régressaient, les transformations acquises étant ensuite transmises héréditairement aux descendants [2].

Un demi-siècle plus tard, le matérialiste Charles Robert Darwin [3] ne fit que reprendre le paradigme défini par Lamarck, mais en laissant irrésolu le problème de l’origine de la vie, puisqu’il se contenta d’avancer une autre théorie pour expliquer selon quelles modalités se serait déroulé le processus de transformation. Alors que Lamarck attribuait tout à la nécessité naturelle, Darwin introduisit une combinaison de hasard et de nécessité. La sélection naturelle indissociable de la compétition pour la vie opérerait sur des petites mutations favorables se produisant par hasard, et la vie les préserverait et les préparerait à d’autres progressions futures. Lorsque Jacques Monod, un siècle après la parution de L’origine des espèces par voie de sélection naturelle (1859), publia son livre sur le hasard et la nécessité, il ne fit donc que reprendre les positions de son lointain inspirateur, sans produire de développements théoriques nouveaux et originaux.

Comme nous l’avons vu (cf. chapitre III), la paléontologie a démontré de manière définitive que l’ensemble des vivants n’a pas toujours été analogue aux vivants actuels, contrairement à ce que pensait Linné, mais a traversé un long devenir. Ce devenir, cependant, ne coïncide en aucune façon avec celui prévu par les deux premiers postulats du paradigme évolutionniste, et correspond au contraire parfaitement à celui défini dans le « Discours sur les révolutions de la surface du globe » (1812) de Georges Cuvier [4]. Il s’est agi, en effet, d’un devenir éminemment discontinu et contrôlé dans le cadre de types morphologiques et structurels particuliers. Ces postulats ne doivent donc plus être considérés comme essentiels pour la science moderne, et un paradigme qui se fonde avant tout sur eux s’avère aujourd’hui construit sur du sable.

Quant au troisième postulat, toute sa valeur suppose que soient définies clairement les lois directrices du devenir biologique. Pour Lamarck, ces lois étaient nécessitantes, donc déterministes. Pour Darwin, elles étaient un mélange de déterminisme et de hasard. Et pour les partisans actuels de la evolutionary vision (Jantsch, Laszlo, etc.) — qui nient d’ailleurs, pour l’essentiel, la validité du deuxième postulat du paradigme évolutionniste —, les lois naturelles obéissent au déterminisme, au hasard et à l’indéterminisme ; pour eux, le processus d’évolution universelle n’est ni univoque ni fortuit, mais orienté selon des champs de possibilités spécifiques, dont il serait impossible de connaître les directions particulières.

En fonction de ce qui précède, on se rend compte aisément que le développement historique du paradigme évolutionniste n’a fait que suivre l’élargissement progressif des critères d’explication scientifique en vigueur depuis deux siècles. Un phénomène est réputé expliqué dès lors qu’on est capable d’indiquer la loi dont sa production n’est qu’un cas particulier.

Or, à l’époque où Lamarck écrivit son principal ouvrage, toute la physique newtonienne avait fait naître la conviction que les connaissances scientifiques ne pouvaient et ne devaient s’appuyer que sur des lois de type déterministe. Selon cette façon de voir, un phénomène est scientifiquement expliqué lorsqu’on peut démontrer qu’il est le résultat d’un enchaînement linéaire de causes et d’effets se déroulant dans le sens de l’irréversible « flèche du temps ». Une chose quelconque ne saurait exister qu’en tant que déterminée par une cause antécédente, elle-même déterminée par une autre cause encore plus antécédente et ainsi de suite en reculant à l’infini dans les profondeurs du passé.

Ce fut Ludwig Boltzmann qui, le premier, en 1866, mit de côté la logique déterministe pour étudier le comportement de phénomènes de caractère collectif, comme par exemple celui des molécules d’un gaz introduit dans un récipient fermé. Dans ce but, il eut précisément recours à des lois probabilistes (ou statistiques) et obtint ainsi des résultats fondamentaux comme la compréhension de la signification physique des principes de la thermodynamique et l’élucidation du concept d’entropie. Ces lois s’appliquent à des phénomènes à déroulement stochastique ou fortuit, pour lesquels vaut donc un principe d’égale probabilité a priori.

Par la suite, on se rendit compte que les explications de type déterministe, de même que celles de type statistique, ne pouvaient assurer la pleine compréhension que d’une partie de la réalité sensible, celle concernant les phénomènes étudiés par la physique classique, et se révélaient inadéquates pour interpréter d’autres phénomènes, comme les comportements au niveau microphysique, la radioactivité et la propagation des ondes électromagnétiques. Il devenait donc nécessaire d’introduire de nouveaux instruments logiques ou de nouveaux systèmes mathématiques en mesure d’expliquer cette seconde classe de phénomènes : des systèmes qui, tout en n’étant pas de nature déterministe, étaient cependant tout aussi précis sur le plan des vérifications expérimentales.

Ainsi, durant les premières décennies du XXème siècle, les fondateurs de la physique quantique et ondulatoire (de Broglie, Heisenberg, Schrödinger, Pauli, etc.) décidèrent-ils d’utiliser des lois indéterministes pour expliquer le comportement des phénomènes microcosmiques, pour lesquels vaut la non-commutabilité des opérateurs, sanctionnée par un principe dit, justement, « d’indétermination ». Ce comportement ne peut pas être décrit de façon exacte et univoque, mais on ne peut pas dire non plus qu’il soit totalement fortuit ou chaotique. Il est inutile de souligner combien l’introduction de ces lois « anticlassiques » a été bénéfique pour la compréhension et la manipulation des énergies subatomiques.

Enfin, au terme de la seconde Guerre mondiale, les fondateurs de la théorie de l’information et de la cybernétique (Shannon, Wiener, Turing, von Neumann, etc.) appliquèrent des lois informationnelles à l’étude et à la réalisation de mécanismes artificiels autorégulés en fonction d’un « programme informant ». Cela inaugura l’ère des ordinateurs, mais fit aussi prendre conscience que ce type de lois pouvait s’avérer singulièrement apte à nous faire mieux comprendre les phénomènes biologiques. Les organismes vivants, en effet, ne se comportent pas comme de simples agrégats mécaniques dépendant passivement des forces du milieu, mais comme des unités autorégulées sur la base d’une loi informante spécifique, qu’on a cru pouvoir identifier, jusqu’à présent, au « code génétique ». Il s’agit donc de véritables systèmes cybernétiques naturels, dont l’extraordinaire degré de complexité et de raffinement ne peut que laisser stupéfait.

Nous avons vu précédemment (cf. chapitre II) que l’existence dans la nature de facteurs « informationnels », donc, en définitive, anti-entropiques, syntropiques et organisateurs, est une conséquence nécessaire des propriétés géométriques des « hypersphères » prévues par la théorie des modèles d’univers de Fantappié et Arcidiacono. Le fait que l’existence de ces facteurs ne soit pas convenablement soulignée par les partisans de la evolutionary vision, voilà précisément ce qui rend cette dernière incomplète et très critiquable.

Il est intéressant, maintenant, de remarquer que l’un des meilleurs épistémologues italiens, Valerio Tonini [5], a souligné à plusieurs reprises que les quatre types d’explication mentionnés — déterministe, probabiliste, indéterministe et cybernétique — ne peuvent pas, en tant précisément qu’ils s’appliquent à des aspects différents de la réalité, être étendus au-delà de leurs domaines respectifs de validité. Ils doivent donc être considérés comme des représentations rationnelles complémentaires de quelque chose qui, en soi, ne saurait être exhaustivement représenté au moyen d’un seul de ces schémas explicatifs. Selon Tonini, la connaissance scientifique n’est donc pas de nature dialectique, mais de nature « synectique », puisqu’elle consiste à adopter simultanément les quatre représentations, le scientifique ne pouvant que « moduler » l’application de l’une ou l’autre de ces représentations aux différentes classes de phénomènes successivement étudiées.

Tout en estimant très intéressante l’approche de Tonini et tout en en acceptant l’orientation générale, je crains cependant qu’elle ne soit susceptible de donner naissance à une grave équivoque. Le fait qu’il soit impossible de nous représenter la réalité au moyen d’un seul type de schéma logique, et qu’il faille pour cela plusieurs types complémentaires entre eux, n’entraîne pas qu’il est impossible de la représenter, de façon unitaire et détaillée, au moyen d’un « système » cohérent de schémas logiques de plusieurs types. La notion de complémentarité, en effet, est une notion relative, qui n’a de sens que dans le cadre logique d’un système de niveau plus élevé : seules les parties d’un système peuvent être dites complémentaires entre elles.

Ainsi se présente donc une tâche très ardue mais fascinante : construire une classification hiérarchique des systèmes logiques, chacun valant en même temps comme « cas particulier » intégré dans un ensemble plus vaste et, à son tour, comme « loi générale » englobant un ensemble de systèmes plus limités. On sait que cette tâche est l’objectif principal d’un courant de pensée relativement récent et désireux d’unifier la pensée scientifique : courant de pensée qui — grâce notamment à Ludwig von Bertalanffy [6] —s’est exprimé en tant que « théorie générale des systèmes » et qui, d’un point de vue épistémologique, représente à mes yeux la contrepartie la plus efficace au bilan négatif du néopositivisme et du criticisme décevant de Karl Popper.

La théorie générale des systèmes se propose d’étudier tous les types de systèmes, afin de découvrir des lois générales gouvernant le comportement de tous les systèmes de même type. Grosso modo, elle a suivi, jusqu’à nos jours, trois directions de recherche parallèles :

— une direction biologique (qui reprend celle du courant « holiste » du début du siècle, et dont relève Bertalanffy lui-même), laquelle met l’accent sur l’observation des systèmes organiques concrets qui se présentent dans la nature, en cherchant à définir des lois générales (comprenant des catégories de plus en plus larges de systèmes) et en tentant de compléter, chaque fois que c’est possible, les théories physiques et mathématiques existantes (de façon à décrire des phénomènes qui ne rentrent pas toujours dans les schémas développés par ces dernières) ;

— une direction mathématique (dont les pionniers furent Claude Shannon et Norbert Wiener), qui conçoit la théorie des systèmes comme une discipline purement abstraite : à partir de certains axiomes et règles d’inférence, on tire les théorèmes qui s’y rapportent, sans s’occuper du caractère effectivement réalisable, ou non, de ces constructions sur le plan matériel ;

— une direction technologique (que nous pouvons faire remonter à M. Turing) qui, contrairement à la précédente, vise à la réalisation concrète de systèmes artificiels ou de machines présentant les caractéristiques d’un comportement « intelligent » : soit en imitant partiellement celles déjà observables dans la nature, soit en en projetant de nouvelles.

Quelle que soit la direction de recherche d’une théorie générale des systèmes, le problème central de celle-ci reste toujours celui d’une classification des systèmes répondant à trois réquisits :

1) permettre d’établir de manière univoque la position occupée par un système donné au sein de la classification ;

2) indiquer, sans aucune ambiguïté, les formalismes mathématiques permettant de décrire un système qui occupe une place donnée au sein de la classification ;

3) une fois définis le type de système et le formalisme mathématique nécessaire à sa description, établir les lois de comportement du système compatibles avec les « conditions de contour » fixées pour le système lui-même [7].

Dans un écrit publié à titre posthume, Fantappié avait déjà abordé avec clarté et rigueur le problème de la classification des systèmes dans le cadre de sa théorie des modèles d’univers [8]. Ses idées peuvent donc être utilisées comme point de départ pour la construction d’une classification répondant aux trois réquisits indiqués et permettant d’unifier les directions de recherche de la théorie générale des systèmes, et surtout d’intégrer de nouvelles théories mathématiques et physiques dans un schéma logique plus large que celui employé jusqu’à présent. Dans cette optique, on perçoit immédiatement le lien étroit existant entre théorie générale des systèmes et théorie des modèles d’univers, puisqu’il devient possible de concevoir chaque système logico-mathématique comme un modèle interprétatif d’univers, en généralisant simplement aux premiers les schémas de classification utilisés pour les seconds.

J’ai déjà parlé (cf. chapitre II) des contributions importantes de l’approche épistémologique de Fantappié à la solution du grand problème de l’unification des lois physiques. Mais ce qu’il faut maintenant mettre en évidence, c’est justement la grande analogie existante entre un « groupe d’opérations » et un système logico-mathématique. Puisqu’un système peut être défini comme un ensemble d’objets + les relations entre ces objets et leurs attributs, il s’ensuit que toute classification de systèmes devra dépendre de deux types de variables : les objets qui composent le système et leurs relations. Chaque groupe d’opérations, alors, ne sera qu’une loi exprimant une certaine relation de correspondance entre deux quantités ou objets mathématiques. Si bien qu’il sera possible de construire une succession hiérarchique au sein de laquelle une quelconque loi d’ordre n se configure simplement comme un système représenté par une relation entre objets d’ordre n – 1.

À ce sujet, le mathématicien Eliano Pessa, de l’université de Rome, a fait remarquer [9] que, si nous utilisons une formule analogue à celle déjà employée pour désigner les différents modèles d’univers, Rnm, où R vaut pour « relation », m pour le type d’objets du domaine de R et n pour le type d’objets du co-domaine de R, et si nous introduisons les 3 règles suivantes :

1) une relation Rnm est un objet de type m + n ;

2) les objets de type 1 sont des nombres ordinaires (réels ou complexes) ;

3) l’ordre d’une relation Rnm (définissable seulement quand m + n est un nombre pair) est donné par l’entier (m + n) / 2 ;

nous aurons la classification suivante qui, évidemment, n’admet pas de limite :

|

Relations |

Type |

Dénomination |

Ordre |

Correspondances n – 1 |

|

R11 |

2 |

Fonction |

1er |

Entre nombres |

|

R12 ; R21 |

3 |

Fonctionnel pur |

Entre nombres et fonctions |

|

|

R22 |

4 |

Opérateur fonctionnel |

2e |

Entre fonctions |

|

R13 ; R31 |

4 |

Hyper-fonctionnel |

2e |

Entre nombres et fonctionnels purs |

|

R23 ; R32 |

5 |

Transformée intégrale |

Entre fonctions et fonctionnels purs |

|

|

R33 |

6 |

– |

3e |

Entre fonctionnels purs |

|

etc. |

… |

… |

… |

… |

Pour compléter la classification, il faut maintenant un critère de distinction entre systèmes en fonction de la nature des objets qui les composent. Ce critère peut être fourni par le fait que les systèmes interagissent, ou non, avec d’autres systèmes qui, par rapport à eux, constituent le milieu extérieur. On appellera ouverts les systèmes de la première catégorie, et fermés ceux de la seconde.

Il est facile de caractériser mathématiquement les deux types de systèmes. Un système ouvert est défini par cinq éléments E, S, I, f, g, où les lettres majuscules désignent les ensembles des entrées (E), des sorties (S) et des états internes (I) possibles, tandis que les minuscules désignent des relations qui à chaque entrée et à chaque état interne associent une ou plusieurs sorties (I), ou bien un autre état interne (g). Au contraire, dans un système fermé, parler des ensembles E et S et de la relation f n’a plus de sens ; ce système sera simplement défini par le couple I, g (où g n’est qu’une relation entre deux états internes). Il est évident, par conséquent, que le problème de la différenciation entre systèmes pourra se ramener à la façon de caractériser opportunément les relations f et g et les ensembles E, S et I.

Le premier cas, et le plus simple, qui puisse se présenter est celui où les ensembles E, S et I sont constitués d’un nombre fini d’éléments et où les relations f et g sont données par des fonctions (relevant donc du schéma R11). En admettant qu’il soit fermé, le système sera alors isomorphe à un système statique (exemple : un cristal) ; mais s’il est ouvert, il représentera ce qu’on appelle un automate fini, doué d’une « mémoire » (à cause de la présence des états internes) et de feed-back ou rétroaction avec le milieu extérieur. Ceci conduit à appeler les systèmes ouverts du nom plus approprié de systèmes cybernétiques, dont le prototype le plus simple ne sera autre, précisément, que les automates finis (il y aura ensuite, selon des niveaux de complexité croissante, les machines de Turing, les automates cellulaires et les Iterative Circuit Computers, dont les comportements présentent des analogies encore plus frappantes avec ceux des organismes vivants).

Considérons maintenant un système continu et essayons de découvrir ses états internes possibles. Cela peut être fait en le caractérisant soit par des valeurs numériques de variables opportunes pensées comme fonctions des coordonnées spatio-temporelles, soit par une seule « fonction d’état » dépendant exclusivement de ces coordonnées. Dans le premier cas, nous pouvons facilement associer ces variables par des relations de 2ème ordre c’est-à-dire par des opérateurs fonctionnels (relevant donc du schéma R22 de relations entre fonctions). Nous obtenons ainsi les équations des systèmes déterministes de la mécanique quantique. Dans le second cas, nous pouvons également insérer la fonction d’état dans des relations R22, mais puisque cela soulèverait des difficultés d’interprétation, on définira des variables caractérisant le système de sorte que la valeur de la variable soit associée à la fonction d’état du système au moyen de relations R12 et R21. Nous tombons alors sur la correspondance entre valeurs propres et fonctions d’état propre à la mécanique quantique. Il est donc évident que la distinction qui vient d’être présentée n’est autre que celle entre systèmes déterministes et systèmes indéterministes. Il y a enfin une troisième possibilité : celle de la connaissance imparfaite des valeurs numériques des variables d’état, qui pourront être remplacées, dans ce cas, par des valeurs de probabilité. Nous aurons alors affaire à des systèmes probabilistes. Nous retrouvons donc la distinction opérée par Tonini, mais avec deux différences essentielles : 1) la distinction ressort logiquement du cadre hiérarchique d’une véritable « théorie générale des systèmes » ; 2) les systèmes informationnels (ou cybernétiques) jouent un rôle fondamental, puisqu’ils intègrent pratiquement toute la succession hiérarchique, incluant en eux les systèmes statiques (ou fermés) comme autant de cas-limites particuliers d’eux-mêmes.

L’énorme implication culturelle de cette conclusion est évidente. Je crois qu’on peut maintenant saisir clairement pourquoi Fantappié a affirmé que la science moderne nous renvoie « aux mêmes conclusions précises » que celles auxquelles étaient parvenus depuis longtemps Aristote et la philosophia perennis. Affirmer que la hiérarchie des systèmes réels est logiquement interprétable en termes cybernétiques, revient à admettre, en effet, que la nature ne peut pas être simplement pensée comme de la matière dominée par le hasard, la nécessité et l’indétermination. Ces trois facteurs existent incontestablement et jouent leur rôle, mais seulement en tant qu’aspects particuliers et complémentaires de la totalité unitaire d’un Systema Naturae constamment réglé par une « loi informante » qui lui est propre. Le fait d’avoir compris que la réalité physique n’est pas seulement constituée de matière (ou de masse-énergie) et de dégradation entropique, mais aussi de forme (ou d’information) et d’organisation syntropique, les deux choses se complétant de façon indissoluble, est à mon avis la révolution scientifique la plus importante de notre siècle. Mais elle n’a pas encore été correctement reconnue ni accueillie par la plupart des scientifiques, qui restent prisonniers d’une mentalité marquée par un réductionnisme surprenant et anachronique.

Avez-vous en tête un exemple particulièrement significatif ?

On pourrait en donner beaucoup, à commencer par Monod. Le prix Nobel français, en effet, reconnaissait explicitement qu’il est juste et utile de considérer les organismes vivants comme des systèmes physiques de type cybernétique ; et pourtant, il continuait à soutenir que l’existence de ces derniers ne s’expliquait que sur la base d’une combinaison de lois probabilistes (le « hasard ») et déterministes (la « nécessité »). Cette attitude réductionniste obligeait d’ailleurs Monod — antifinaliste acharné — à introduire comme deus ex machina un facteur de saveur aussi finaliste que celui, précisément, de « téléonomie ». De même, les représentants de la evolutionary vision, bien qu’ils affirment s’appuyer sur ce que nous enseignent les modernes « sciences des systèmes », finissent en réalité par tout ramener à une simple combinaison d’explications probabilistes, déterministes et indéterministes. Mais toutes ces prétentions issues d’un réductionnisme interprétatif me paraissent illicites et illusoires.

Il est illusoire de prétendre expliquer le « phénomène vivant », dans sa globalité, en le réduisant simplement à la logique afinaliste inhérente au paradigme évolutionniste : que celui-ci soit de type lamarckien, darwinien ou « systémique » au sens de Laszlo. La logique de la vie, je le répète, n’est pas linéaire, elle est circulaire.

Comme l’ont clairement réaffirmé le biologiste français Louis Bounoure [10], le physicien allemand Walter Heitler [11] et notre compatriote Tonini, elle inclut aussi bien le déterminisme que la finalité. Elle ne se réduit pas à une pure variabilité cinématique, elle est essentiellement stabilité dynamique. Par conséquent, de même que se demander si c’est l’œuf qui fait la poule ou le contraire n’a pas de sens, de même cela n’a aucun sens de se demander si ce sont les cellules qui font les tissus ou l’inverse. Cela n’a pas de sens non plus de se demander si ce sont les tissus qui déterminent les organes, ou les organes qui déterminent les organismes, ou les organismes qui déterminent les taxa, plutôt que le contraire. Toutes ces alternatives ne tiennent pas. Ou, si l’on préfère, elles tiennent toutes en même temps, en tant qu’elles dépendent inséparablement les unes des autres. Cela a été parfaitement compris par Orlando Gregorini dans sa Biologia relativistica, bien qu’il n’en ait pas tiré toutes les conséquences logiques, mais ait continué de maintenir le paradigme évolutionniste, au lieu de le mettre définitivement de côté [12].

Je vous avoue que tout cela me laisse un peu perplexe. Je peux comprendre que se demander si c’est l’œuf qui fait la poule ou l’inverse est privé de sens. Mais il m’est plus difficile d’admettre qu’il est également privé de sens de se demander si ce sont les cellules qui déterminent les tissus, ou les tissus les organes, ou les organes les organismes, plutôt que l’inverse. À en juger par le cours du développement embryologique, il semble que les premières affirmations soient vraies, non les secondes.

Et pourtant non. Les deux alternatives sont vraies. La cellule-œuf fécondée se transforme en morula, la morula en blastula et la blastula en gastrula. Puis, selon le groupe systématique auquel appartient l’animal que nous observons, l’ensemble des cellules qui composent la gastrula se différencie en parties distinctes, qui donneront naissance aux différents tissus et organes de l’adulte. Toutes ces différenciations et complexifications ne peuvent cependant être vues comme le simple effet de précédentes causes mécaniques ou déterministes. C’est toujours le vieux débat entre préformisme et épigenèse, resté très vif jusqu’à l’époque de Bonnet et de von Baer, mais dont la conclusion ne peut qu’être favorable à la seconde.

En effet, si le développement embryologique procédait vraiment en conformité avec la logique préformiste, donc de façon afinaliste et déterministe, les parties différenciées de l’organisme (exemples : le système nerveux, l’appareil musculaire, l’appareil circulatoire, etc.) devraient dériver d’autant d’ébauches différentes, lesquelles devraient être présentes dès les premières phases, agissant comme des « causes initiales » de ces parties. Mais en réalité, comme l’avaient déjà bien compris les embryologistes holistes de la première moitié du XXème siècle, il n’en est pas ainsi.

Bernhard Dürken, par exemple, écrivait : « Au début du développement, comme cela a été expérimentalement démontré, seules sont présentes un certain nombre d’‘ébauches’, qui ont cependant une valeur très différente de celle que leur attribue l’idée préformiste ; elles ne sont pas les conditions initiales directes des organes, mais créent plutôt par la suite seulement, à travers une organisation progressive, les fondements proprement dits des organes. Les rapports réciproques et la coopération harmonieuse de toutes les actions qui partent des ébauches initiales relativement peu nombreuses créent réellement quelque chose de nouveau. Ainsi apparaissent tout d’abord des organisateurs d’ordre inférieur, dont les influences coordonnées accroissent à leur tour progressivement l’organisation et, par conséquent, les structures de l’embryon, pour finir par constituer les fondements proprement dits des organes ; ceux-ci peuvent participer de manière analogue à l’organisation ultérieure, jusqu’à ce qu’on atteigne à la fin cette grande complexité et cette grande variété de parties, qui caractérisent l’individu au terme de son développement » [13].

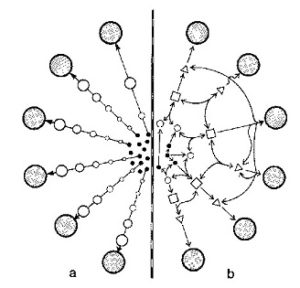

Puisque les ébauches des différentes parties ne sont pas présentes au début du processus embryonnaire, mais se forment dans un deuxième temps seulement, à la suite d’actions et de rétroactions, harmonieusement corrélées entre elles, de substances organisatrices spécifiques (les « organisateurs de Spemann ») sur les différentes zones cellulaires, il s’ensuit que l’ensemble des tissus et des organes ne peut pas résulter des seules actions mécaniques et afinalistes — indépendantes les unes des autres — des cellules initiales, mais bien d’actions de ces cellules qui, étant coordonnées entre elles, obéissent nécessairement à une certaine finalité spécifique inhérente au système qui les inclut (figure 6).

Comme dans les systèmes cybernétiques, par conséquent, le développement des systèmes vivants n’est pas causé par le seul mouvement mécanique des éléments qui les composent, mais essentiellement par le « programme informant » qui leur est spécifique. Ce programme peut être compris comme une totalité logique unitaire exprimant toute la structure spatio-temporelle (présent, passé et futur) du système lui-même. C’est précisément comme si existaient dans ce système, en puissance ou à l’état virtuel, des structures qui se manifesteront ensuite, actualisées, selon un certain ordre et en interagissant selon un certain mode. Et c’est cela l’épigenèse, telle qu’Aristote la définit dans sa Génération des animaux.

Ne trouvez-vous pas que c’est une tentative plutôt ardue que de vouloir faire accepter l’idée de formes de causalité qui ne se déroulent pas « du passé en direction de l’avenir », mais aussi — carrément — « de l’avenir en direction du passé » ?

J’en suis bien conscient. Mais je suis tout aussi convaincu qu’il y a désormais des éléments suffisamment solides pour nous amener à faire cette tentative, sans la perspective de devoir battre en retraite précipitamment. L’épistémologie moderne, en effet, surtout à travers l’œuvre de grands physiciens comme l’Argentin Mario Bunge et le Français Olivier Costa de Beauregard, est arrivée à la conclusion que la notion de causalité ne se ramène pas au déterminisme, au sens classique et newtonien du terme, mais qu’elle est aussi, en soi, rigoureusement intemporelle.

|

Figure 6 Schéma illustrant les relations entre « ébauches initiales » (points noirs) et « structures définitives » comme les organes, propriétés, etc. (cercles parsemés de points) durant le processus embryogénétique. À gauche : relation déterministe et linéaire, en fonction de laquelle les ébauches se développent directement dans les structures définitives (développement de type préformiste : à tant d’ébauches correspondent tant de structures définitives). À droite : relation cybernétique et « mutualiste », en fonction de laquelle les structures sont le résultat de la coopération harmonieuse des ébauches, par référence à la logique unitaire de la structure spatio-temporelle dont elles sont partie intégrante (développement de type épigénétique : les ébauches sont en nombre bien plus restreint que les structures définitives) (d’après B. Dürken). |

Bunge [14] confirme que sans la notion de causalité aucune science ne saurait être construite ; mais il affirme que la grande erreur a été d’identifier sans moyen terme la causalité à la détermination. La détermination, en effet, n’est qu’un type particulier de causalité : il faut donc refuser que celle-ci soit identifiée à l’une de ses modalités. Cela étant, Bunge voit dans la causalité statistique un type de légalité non moins valable que la légalité déterministe. Tout aussi valable est la légalité qui caractérise une catégorie de causalité appelée spontanée ou « de l’automouvement », et qui correspond assez bien à la causalité de type cybernétique présidant aux phénomènes du vivant. Bunge, enfin, repousse fermement l’extrapolation métaphysique inhérente à une certaine interprétation — qu’on est en droit de contester — de la physique quantique : l’interprétation de Bohr et de l’« École de Copenhague », selon laquelle rien dans la nature, d’après le principe de Heisenberg, ne pouvant être déterminé, aucune causalité sûre ne peut exister.

Causalités déterministe, statistique, spontanée (ou cybernétique) et aussi indéterministe. Tout cela s’accorde assez bien, me semble-t-il, avec la distinction des différents types de loi scientifique établie par Tonini.

Exact. Et cela nous autorise aussi, entre autres choses, à ne faire aucune différence, sur le plan scientifique, entre l’idée de « causalité » et celle de « système logique explicatif » (de quelque type que puisse être ce dernier : déterministe, statistique, indéterministe ou cybernétique). Si l’on démontre qu’un certain phénomène peut être reconduit à un système logico-mathématique donné, on pourra aussi en conclure que ce phénomène est causé, et pas seulement expliqué, par la loi qui informe ce système.

Venons-en maintenant à Costa de Beauregard.

Ce physicien a effectué la recherche la plus profonde, peut-être, parmi toutes les recherches épistémologiques menées jusqu’à maintenant sur un problème crucial et particulièrement épineux de la physique contemporaine : celui du temps et de son irréversibilité. Mais puisque ce problème est généralement mal connu du grand public, avant même d’expliquer comment Costa de Beauregard a cru pouvoir le résoudre, il me semble nécessaire d’en rappeler les termes essentiels.

J’y ai fait allusion précédemment : l’une des caractéristiques fondamentales de la physique de notre époque, c’est qu’elle nous oblige à détacher les concepts sur lesquels doit reposer une vision vraiment scientifique de la réalité des conditionnements induits par le sens intuitif commun et routinier (les « expériences sensées », comme disait Galilée [15]). Et parmi ces concepts, il faut tout d’abord mettre au premier plan ceux d’espace et de temps, qui ont, pour le sens commun, une signification pratiquement opposée à leur signification scientifique.

La plupart des gens, en effet, pensent à l’espace comme à une sorte de « vide » ou d’immense « récipient » dans lequel serait contenu tout l’univers, avec toutes ses galaxies. Lorsqu’il y a des corps bien distincts dans ce vide ou dans ce récipient, l’espace ne cesse pas d’exister, il est simplement « rempli ». Cette conception de l’espace comme absence d’objets interdit notamment à beaucoup de gens de comprendre pourquoi les scientifiques s’acharnent à bâtir théorie sur théorie à son sujet. Après tout, si l’espace est un « vide », un « rien », qu’est-ce qu’on peut dire de lui ?

Mais, en réalité, les physiciens ont une vision totalement différente de l’espace, puisqu’ils le considèrent comme un plenum doué de caractères bien définis, support d’énergies multiformes, trait d’union entre tous les corps et éléments de la réalité, nécessaire pour assurer la cohérence des actions physiques entre des régions éloignées et pour faire de l’univers une totalité organique. Les objections bien connues des physiciens modernes contre l’« éther cosmique » classique ne sont valables que tant qu’elles se rapportent à une conception particulière, mécaniste, de ce noyau spatial, non contre son existence et sa fonction de facteur de connexion universelle. Si on l’entend comme totalité de son contenu (particules élémentaires, radiations, atomes, planètes, étoiles et galaxies), l’idée d’éther ou d’espace s’identifie donc à celle d’« univers » et de « substance matérielle » cosmique.

On peut développer des considérations tout à fait analogues au sujet du temps. Pour le sens commun, en effet, le temps est une réalité nettement distincte de l’espace : alors que l’espace se présente comme immobile et passif, le temps, lui, se présente comme une sorte de flux ou d’écoulement ininterrompu et inexorable, comme un passage irréversible du passé au futur que parcourt notre expérience consciente du moment présent au moment suivant. Mais du point de vue rigoureusement scientifique, les choses sont bien différentes, comme on le comprendra à l’aide des citations suivantes.

Albert Einstein : « Pour nous physiciens la séparation entre passé, présent et futur est une illusion pure et simple, mais qui est dure à mourir » [16].

Paul C. Davies : « Le besoin d’un temps qui s’écoule, mobile, n’est apparu à aucune étape du progrès de la physique théorique. Le monde de la relativité est décrit par une carte quadridimensionnelle statique. Le temps qui entre dans les équations de la physique théorique semble donc privé de cette qualité essentielle du temps psychologique humain » [17].

Giuseppe Arcidiacono : « À la lumière de la physique moderne d’Einstein, cette idée si simple et naturelle d’un temps et d’un espace indépendants, s’est révélée inexacte, et l’on est arrivé à cette extraordinaire conclusion que le temps est étroitement lié à l’espace, étant donné qu’il se comporte comme une ‘quatrième’ dimension de l’espace. Cela revient à dire (mais tout le monde n’y pense pas) que nous n’avons plus un temps comme celui que nous avions imaginé, à savoir caractérisé par un passage continu du présent depuis le passé vers le futur, de l’être vers le non être. Il est faux de dire que seul ‘existe’ le présent, et que le passé tombe dans le néant parce qu’il n’est plus, tandis que le futur n’existe pas encore. Ce n’est là qu’une illusion de nos sens limités. En réalité, l’espace et le temps forment une seule entité, qui ‘existe’, comme le soutenait le grand mathématicien Fantappié, dans sa totalité de passé-présent-futur, comme un tout unique. Voici donc qu’une des théories les plus ardues et les plus abstraites de la mathématique, à savoir la théorie des ‘hyperespaces’ (espaces à plis de trois dimensions), et qui avait été taxée de science-fiction pure et simple au moment de son apparition, devient partie intégrante de la physique, la renouvelant et la révolutionnant jusque dans ses fondements, lui ouvrant ainsi la voie vers les succès qu’elle obtiendra au XXème siècle » [18].

Louis de Broglie : « Dans l’Espace-Temps, tout ce qui pour chacun de nous constitue le passé, le présent et le futur est donné en bloc. Chaque observateur, au fil du temps, découvre, pour ainsi dire, de nouvelles tranches d’Espace-Temps qui lui apparaissent comme les aspects successifs du monde matériel, bien qu’en réalité l’ensemble des événements constituant l’Espace-Temps existent antérieurement à la connaissance qu’il en a » [19].

Hermann Weyl : « Le monde objectif simplement est, il ‘n’advient’ pas » [20].

Luigi Fantappié : « L’univers naturel est, dans sa totalité quadridimensionnelle (localisé dans l’espace-temps ou chronotope à quatre dimensions), et il est donné tout entier avec toutes ses lois, qui sont donc en réalité — même quand elles incluent le temps et semblent par conséquent, à première vue, des lois du devenir — des lois statiques, des lois architectoniques de cette immense construction immobile qui s’étend simultanément dans les quatre dimensions du temps et de l’espace » [21].

Olivier Costa de Beauregard : « La Relativité ne peut pas concevoir la matière autrement que comme actuellement déployée sur l’épaisseur du temps tout autant qu’elle est étendue dans l’espace ; ceci, pour la raison trivialement technique qu’il est impossible de tracer objectivement une frontière entre le ‘déjà accompli’ et le ‘non encore accompli’. Contrairement à ce qu’il semble à nos psychismes, ces deux catégories ne sont pas objectivement disjointes. Il est donc devenu impossible de concevoir le temps de l’univers matériel comme un front qui avance. Le temps de l’univers matériel est, au même titre que son espace, une étendue actuelle ; et le paramètre explorateur de cette ‘quatrième dimension’ est, tout comme ceux qui paramètrent l’espace ordinaire, une coordonnée » [22].

Pour la physique de notre temps, en somme, espace et temps sont complètement équivalents et unifiés dans un continuum à quatre dimensions (hyperspatial), où les interactions entre les événements-objets matériels s’étendent dans chaque direction.

Dans une note de Dopo Darwin, et afin de faire mieux comprendre la valeur relative du temps, j’avais proposé un exemple qui rappelait très vaguement celui du prisonnier dans la caverne de Platon. L’exemple était le suivant. Imaginons une colonne de soldats marchant dans une rue d’une ville, où se trouve une porte qui introduit dans une pièce sans fenêtre. Imaginons aussi qu’en raison d’un destin très malheureux, un homme ait toujours vécu enchaîné au fond de cette pièce. Si la porte s’ouvrait à l’improviste, l’homme verrait les soldats apparaître l’un après l’autre d’un côté de la porte, à travers l’encadrement de celle-ci, puis disparaître par le côté opposé. Puisque les soldats qui ont déjà traversé l’encadrement de la porte ne sont plus visibles, le prisonnier pourrait se croire autorisé à soutenir qu’ils n’existent plus (en tant qu’ils font désormais partie du passé) ; tandis que ceux qui n’ont pas encore atteint l’encadrement n’existent pas (en tant qu’ils font partie du futur). Mais si le prisonnier pouvait se libérer de ses chaînes, monter dans un hélicoptère et observer de là-haut toute la scène, il verrait d’un seul coup d’œil toute la colonne de soldats, et ce qui auparavant lui apparaissait subdivisé en trois classes de phénomènes (présents, passés et futurs) et en devenir, serait alors pour lui, en réalité, un événement unique.

Cet exemple devrait suffire à faire comprendre que l’impression du devenir est simplement relative à notre point de vue d’êtres humains, et qu’un être non soumis à nos limitations verrait, comme déployé devant lui, tout le cadre spatio-temporel de la réalité, avec tous les éléments ou événements de celle-ci étroitement reliés les uns aux autres comme les tesselles d’une mosaïque. La notion d’existence, limitée au présent pour le sens commun intuitif, devrait être étendue — comme le soutenait Fantappié dès 1948 — à la totalité du passé et du futur ; mais cela reviendrait à affirmer que les phénomènes naturels dépendent étroitement, non seulement de causes passées, mais aussi de fins (ou anti-causes) futures.

C’est ici que peut venir s’insérer opportunément l’œuvre de Costa de Beauregard. Le physicien français fait observer que les faits précédemment exposés mènent à plusieurs problématiques, toutes d’extrême importance — me semble-t-il — afin de construire une hypothèse capable de remplacer l’évolutionnisme biologique. Ces problématiques concernent essentiellement la signification de l’asymétrie ou irréversibilité temporelle, la valeur effective de la notion courante de causalité et la position particulière des êtres vivants au sein du chronotope relativiste.

Voyons l’une après l’autre ces problématiques.

Je commencerai par celle de l’asymétrie. S’il est vrai que les différents événements réels sont des structures spatio-temporelles statiques en elles-mêmes, nous pouvons alors distinguer des événements symétriques et des événements asymétriques. Exactement comme, du point de vue purement spatial de leur forme extérieure, une marguerite, une palourde, un oursin et un cheval sont des êtres symétriques (on peut en effet distinguer en eux une partie « droite » et une partie « gauche », voire plusieurs parties identiques entre elles), tandis qu’un olivier, un escargot et la ramification d’un corail ne le sont pas du tout ; de même, du point de vue temporel, il y a des événements symétriques (ex. : l’oscillation régulière d’un pendule, ou bien le trajet d’un astéroïde qui des profondeurs de l’espace se meut en direction du soleil, l’effleure et puis continue dans la même direction, s’éloignant de plus en plus pour replonger de nouveau dans l’espace) et des événements asymétriques (ex.: la lente combustion d’une bougie ou les ondes produites à la surface d’un étang par une pierre qui y est jetée).

Nous voici donc devant le premier problème. Si nous intervertissons la coordonnée temporelle d’un événement symétrique (en le filmant éventuellement sur la pellicule, puis en projetant celle-ci à l’envers), cet événement continuera à présenter le même comportement, en accord parfait avec toutes les lois de la physique. Mais si nous intervertissons la coordonnée temporelle d’un événement asymétrique, celui-ci présentera un comportement qui, s’il se vérifiait réellement, nous ferait crier au miracle. Dans le cas de la bougie, en effet, nous verrions un tas informe de cire, d’où émergerait une mèche enflammée ; puis nous verrions ce tas prendre la forme d’un petit cylindre très bas, et absorber continuellement la cire en fusion en fonction de la flamme et s’étirer peu à peu dans un sens vertical, jusqu’à ce que la flamme s’éteigne, que la mèche devienne blanche et que la bougie soit devenue tout à fait nouvelle. Quant au second exemple, nous verrions l’eau de l’étang commencer à se rider à proximité des rives, puis former des ondes centripètes qui iraient se concentrer de plus en plus rapidement en un seul point, où elles cesseraient brusquement d’exister et d’où jaillirait une pierre. Eh bien, ces comportements « miraculeux » seraient eux aussi en accord parfait avec toutes les lois de la physique ! Ce qui représente précisément l’un des paradoxes les plus épineux de la science moderne.

Il existe des dénominations pour ces deux types opposés de phénomènes. Le type de mouvement ondulatoire « normal », où le trouble se propage de sa source vers l’extérieur, est appelé mouvement ondulatoire retardé, tandis que le mouvement ondulatoire « miraculeux », où le trouble passe par un point lointain avant d’arriver à la source pour y disparaître, est désigné comme mouvement ondulatoire anticipé.

Dès 1944, Fantappié avait clairement souligné le fait que les lois de la propagation des ondes ne font aucune différence entre les ondes anticipées et les ondes retardées. Lorsqu’on résout, par exemple, les équations électromagnétiques de Maxwell ou les équations fondamentales de la mécanique quantique, les premières comme les secondes comprennent des solutions tant pour les ondes anticipées que pour les ondes retardées. Fantappié en déduisait qu’il était par conséquent obligatoire de les accepter ensemble, en les mettant en relation avec deux catégories opposées mais complémentaires de phénomènes : les phénomènes entropiques et les phénomènes syntropiques. Les premiers sont ceux régis par le principe déterministe, et fondés sur le calcul des probabilités en « prédiction aveugle » et sur la loi de l’augmentation progressive de l’entropie, par le passage d’états d’improbabilité élevée (c’est-à-dire organisés et hétérogènes) à des états toujours plus probables (c’est-à-dire désorganisés et homogènes). Par contre, les phénomènes syntropiques sont régis par un principe téléologique ou finaliste, et fondés sur le calcul des probabilités en « rétrodiction aveugle » ; ils obéissent à la loi de l’augmentation de la néguentropie ou syntropie, par le passage d’états de probabilité maximale (c’est-à-dire désorganisés et homogènes) à des états toujours plus improbables (c’est-à-dire organisés et hétérogènes).

Jusqu’à présent, la grande majorité des physiciens n’a pas accepté le point de vue de Fantappié, bien qu’on ne soit jamais parvenu à démontrer qu’il n’était pas fondé. Ils ont régulièrement repoussé les solutions représentées par les potentiels anticipés, pour ne prendre en considération que les potentiels « normaux », donc retardés. Mais tous ne partagent pas cette façon de procéder et certains la jugent même arbitraire. John Wheeler et Richard Feynman, par exemple, deux des plus grands physiciens américains de l’après-guerre, ont démontré qu’il est strictement équivalent de décrire le système des particules élémentaires chargées et de l’irradiation soit de façon chimique, soit de façon « anticlassique » au moyen d’ondes anticipées, soit encore au moyen d’ondes semi-retardées et semi-anticipées. Et Costa de Beauregard écrit pour sa part : « Lorsque nous avons recherché comment se justifie réellement l’irréversibilité des phénomènes (si bien décrite par la Mécanique statistique), nous n’avons trouvé pour commencer qu’un impératif décret, un écriteau ‘sens interdit’ opposé à la rétrodiction aveugle. Lorsqu’ensuite nous avons voulu nous enquérir des attendus motivant cette interdiction formelle, nous nous sommes trouvés renvoyés de la loi de l’entropie croissante au principe des actions retardées, puis réciproquement de la loi des actions retardées au principe de l’entropie croissante, comme dans l’apologue célèbre de l’œuf et de la poule, dont on ne saurait vraiment dire lequel est venu d’abord » [23].

Mais, on l’a déjà vu, dans le cadre de la théorie de la relativité, il est non seulement recommandé, mais imposé comme obligatoire, de considérer l’univers comme réellement déployé dans l’immobilité d’un continuum spatio-temporel.

« Il devient donc tout à fait erroné — écrit encore Costa de Beauregard — de penser ou de dire que ‘le temps de l’univers porte constamment l’univers vers ses états les plus probables, et ne l’en tire pas’, ou d’autres expressions équivalentes qu’on peut trouver, notamment, dans toutes les discussions épistémologiques du principe de Carnot (…) L’univers de la relativité étant un bloc spatio-temporel déployé ne varietur comme un objet statique à quatre dimensions, tout ce qu’on peut objectivement dire est qu’il est ainsi agencé que, dans une épaisseur de temps limitée autour de ce que nous pouvons explorer, ses états (tridimensionnels curvilignes) sont rangés de proche en proche dans un même sens d’évolution de l’entropie ou de la probabilité macroscopique. Mais alors, la question qu’un Poincaré se posait dans Science et Méthode sous la forme : pourquoi l’univers en évolution est-il celui que nous connaissons, et non pas l’univers temporellement symétrique où le principe de Carnot jouerait à rebours ? doit être ainsi reformulée : ‘Pourquoi le temps des êtres vivants ou conscients explore-t-il la dimension temporelle de l’univers dans le sens qui fait apparaître les entropies comme croissantes et les actions comme retardées, et non pas dans le sens contraire’ ? » [24].

De même que l’avait fait Fantappié en 1955 [25], Costa de Beauregard, en somme, en conclut que la « flèche du temps », telle que nous la percevons, n’a pas de valeur absolue. Au contraire, elle est de nature essentiellement biopsychologique, et semble représenter uniquement « une adaptation nécessaire de la vie et de la conscience aux conditions de l’univers quadridimensionnel » [26]. Si une telle « adaptation » n’avait pas lieu, en effet, la prédiction statistique aveugle utilisée par toutes les sciences (comme celle complètement intuitive pratiquée par un docker ou par un joueur de billard, et même celle de tout homme à chaque instant de sa vie) serait impossible. N’importe quelle action serait donc impossible. Il y a plus : il ne serait même plus possible de s’instruire grâce à l’expérience. Imaginons, par exemple, le phénomène « temporellement renversé » de la lecture d’un livre : en le lisant à l’envers, de la dernière page à la première, on finirait par effacer une partie de la somme d’informations possédées au départ, donc par devenir plus ignorant !

C’est la structure de notre psychisme, par conséquent, qui nous oblige à feuilleter les pages du grand livre cosmique (c’est-à-dire les états tridimensionnels contigus au continuum à quatre dimensions) dans l’ordre de la probabilité croissante, même si — théoriquement — les mêmes pages pourraient très bien être feuilletées dans l’ordre inverse.

Et cela nous mène directement à la seconde des trois problématiques abordées par Costa de Beauregard : celle concernant la notion de causalité. Il est évident, en effet, que s’il est vrai que la « flèche du temps » a une valeur essentiellement relative à notre structure biopsychologique particulière, on doit en dire de même de la notion courante de cause qui, nous le savons, dépend étroitement de cette « flèche ».

Galilée affirmait que « la cause est telle qu’une fois posée, l’effet s’ensuit ; et qu’une fois disparue, l’effet disparaît » [27].

Justement. L’anti-aristotélicien Galilée et toute la science venue après lui et fidèle à sa façon de voir, savaient très bien que cette acception de la notion de cause est beaucoup plus étroite que celle employée dans le domaine philosophique ; malgré tout, cette acception fut élevée au rang de critère universel de jugement scientifique. Aujourd’hui, au contraire, et à la suite de l’application du calcul des probabilités et de la théorie d’Einstein, nous nous rendons compte, avec Bunge, que la notion courante de cause correspond simplement à une catégorie particulière de la causalité, la catégorie déterministe. Et en même temps, nous nous apercevons qu’Aristote était, en l’occurrence, bien plus proche de la vérité que Galilée, parce qu’il distinguait explicitement, à côté d’une notion de cause efficiente (de nature déterministe et « retardée »), une notion de cause finale (de nature téléologique et « anticipée »), les considérant toutes deux comme complémentaires et correspondant, sous l’aspect dynamique, à l’autre dualité complémentaire cause matérielle-cause formelle, qui a, elle, une signification statique [28].

Si vous vous souvenez, lorsque je parlais il y a peu de la réalité naturelle comme d’un continuum à quatre dimensions, je la comparais à une gigantesque mosaïque, dont les différentes tesselles correspondaient à autant d’éléments-événements. Eh bien, de même que, dans une mosaïque, chaque tesselle n’a de sens qu’en relation avec toutes les autres, qu’elles soient placées sur sa droite ou sur sa gauche, de même chaque événement est inextricablement lié à tous les autres événements du chronotope. Il ne peut donc pas être vu comme causé uniquement par des processus de caractère déterministe (courant « depuis le passé »), mais aussi par des processus de caractère finaliste (se déroulant « depuis le futur »). Et le fait que les deux types de processus doivent avoir lieu dans la nature, voilà qui est parfaitement prévu par la théorie unitaire des « modèles d’univers » de Fantappié et d’Arcidiacono.

En fonction de ce qui a été dit jusqu’ici, on comprend donc très bien les conclusions auxquelles parvient Costa de Beauregard au sujet du problème de la causalité : « L’on peut bien dire que la notion de causalité, dans son emploi par le praticien ou le théoricien (…) a été souvent vague, protéiforme, encombrée d’un anthropomorphisme inconscient et des préjugés caractéristiques d’un stade préépistémologique de la pensée ; c’est pourquoi l’on doit se féliciter lorsque la Physique est amenée à préciser très clairement l’énoncé des formes du principe de causalité dont elle se sert. Mais au philosophe, à la lumière des présentes analyses, nous serions tenté de dire ceci : dans son rapport avec le temps, la causalité est l’affaire sinon, certes, exclusive, du moins grandement l’affaire du physicien. Une définition métaphysique de la causalité ne peut être pure que si elle est rigoureusement intemporelle dans sa conception ; et que si, dans son application, elle se garde ‘comme du feu’ des entraînements subrepticement liés à la conjugaison des divers ‘temps’ des verbes » [29].

L’interprétation des phénomènes quantiques par Costa de Beauregard, interprétation particulière et à coup sûr hétérodoxe, ainsi qu’une bonne partie de l’ossature conceptuelle de la théorie des modèles d’univers, peuvent donc être justifiées à la lumière de la perspective selon laquelle rien ne peut empêcher d’envisager les potentiels anticipés, en plus des potentiels retardés. Mais cela a pour conséquence que toute relation causale qui se déroule dans le temps doit être construite, non plus seulement à partir de données du temps initial, mais aussi — et simultanément — en tenant compte des conditions finales. Nous pourrions, je crois, revenir plus loin sur cette question.

Il nous reste donc à voir la dernière problématique : celle relative à la place particulière des êtres vivants au sein du chronotope relativiste.

Oui. C’est surtout en tenant compte de cette problématique, à la lumière de ce qu’on a énoncé jusqu’à présent, qu’on peut voir clairement, à mon avis, les insuffisances du paradigme évolutionniste.

Costa de Beauregard s’arrête assez longuement sur le rôle joué par les vivants dans l’ensemble spatio-temporel de l’univers. Il fait remarquer que, dans un contexte généralisé des lois physiques (donc non plus faussé par le préjugé consistant à considérer comme vraie la seule classe de phénomènes fondés sur les actions retardées et sur le principe de l’entropie croissante), les études de cybernétique et celles en rapport avec la théorie de l’information, dues à différents auteurs — dont, notamment, L. Brillouin, D. Gabor et J. Rothstein —, acquièrent une importance fondamentale. Ces auteurs, en effet, ont démontré qu’il y a une profonde communion de nature entre une information acquise et une preuve au sens du calcul des probabilités. Ce qui permet de conclure que l’entropie d’un système est tout à fait équivalente à l’épaisseur de notre manque d’information sur ce système. L’entropie peut et doit donc être mise en relation numérique avec l’information qu’il est possible de tirer de n’importe quelle expérience ou mesure physique.

Ce fait a conduit à deux résultats d’un intérêt capital :

1) l’acquisition d’une information ne peut se produire qu’au détriment d’un accroissement concomitant de l’entropie universelle [30] ;

2) toute information acquise équivaut donc à la possibilité de remettre un système dans un état plus ordonné que celui où il a été trouvé.

Le premier de ces résultats a une implication directe : puisqu’il existe une relation organique entre l’information acquise par les organismes vivants et la variation d’entropie de l’univers, il s’ensuit qu’il y a un lien insécable entre vie, psyché et le reste de l’univers. Pour Costa de Beauregard, cette conclusion est décisive et nous enseigne qu’une vision physique stricto sensu du cosmos est trop limitée. Il estime donc que la physique sera tôt ou tard obligée d’entamer un dialogue actif avec la psychologie au sens large du terme, afin de jeter les bases d’une science beaucoup plus compréhensive.

Quant au second résultat, il montre qu’il y a une étroite équivalence entre l’information et la néguentropie (ou syntropie, pour reprendre le terme introduit pour la première fois par Fantappié).

Si nous cherchons maintenant à combiner entre eux ces résultats, nous nous apercevons qu’il n’y a pas de différence de nature, mais seulement de grandeur numérique, entre les deux transitions cybernétiques fondamentales « syntropie ? information » et « information ? syntropie ». La première de ces transitions consiste à acquérir de l’information au prix de la dégradation d’une partie de l’ordre universel. Elle correspond donc à l’observation, à l’acquisition de connaissance, et rentre dans la classe des transitions banales de type déterministe, ou retardées. La seconde transition, en revanche, consiste à produire de l’ordre au prix d’une information. Elle correspond donc à l’action, au pouvoir d’organisation, et rentre dans la classe des transitions de type finaliste ou anticipé.

Si je ne m’abuse, il me semble que cette fois encore nous sommes revenus à Aristote. Pour le philosophe grec, en effet, connaissance et action étaient des réalités complémentaires, inséparablement liées.

Très juste ! « Information » signifiait, pour Aristote, aussi bien la connaissance qu’on peut acquérir, que le pouvoir d’organisation. Mais au cours des siècles, seule la première de ces acceptions a été reprise dans les milieux scientifiques, tandis que la seconde s’est trouvée reléguée, de fait, dans les petits cercles des philosophes intéressés par la notion de finalité. Une seule théorie pouvait la réintroduire de plein droit dans le domaine des choses démontrables : la cybernétique, « la plus aristotélicienne des théories physiques », comme a dit Costa de Beauregard. Connaissance et action, en effet, sont parfaitement symétriques en droit, bien qu’en fait la seconde soit beaucoup plus difficile à réaliser que la première. Écrire un livre, c’est bien plus difficile que de le lire. C’est un peu comme, dans un autre domaine, l’électron positif ou positron, qui, bien que symétrique en droit par rapport à l’électron négatif, est en fait beaucoup plus rare.

Et le rôle des organismes vivants dans le chronotope ?

J’y arrive. Nous avons dit que l’existence d’un lien profond entre les organismes vivants et le reste du monde est désormais scientifiquement démontrable. Des flux de syntropie, en effet, échappent au cosmos matériel pour y retourner après avoir circulé dans les organismes vivants sous la forme d’information non matérielle. Chaque abeille enlève de la syntropie au milieu pour acquérir des informations, puis la restitue dans la structure à alvéoles régulières de la ruche, à la construction de laquelle elle participe. Chaque agriculteur soustrait de la syntropie à l’environnement, puis la restitue avec la disposition ordonnée de ses champs cultivés. Et ainsi de suite. Les exemples pourraient être multipliés à l’infini.

Le bloc spatio-temporel doit donc être conçu comme incluant les effets de la présence des vivants. Non pas seulement le corps des vivants, mais aussi leur psychisme, qui, dans la mesure où il interagit avec le monde matériel, doit être considéré comme coextensif à ce bloc. En particulier, c’est le psychisme inconscient qui doit être considéré comme coextensif, alors que le psychisme conscient ne peut qu’avancer le long de la quatrième dimension du bloc, dans le sens en fonction duquel il peut acquérir de l’information [31].

Les vivants, en somme, sont partie intégrante de la totalité cosmique quadridimensionnelle et, par là même, sont aussi inséparablement interconnectés. « Tous les êtres vivants, dans tous les lieux comme dans tous les temps, se tiennent. L’humanité entière, dans l’espace et dans le temps, est une immense armée qui galope à côté de chacun de nous, en avant et en arrière… », écrivait le philosophe Henri Bergson [32]. Et dans cette course galopante, qui sur le plan conscient est entièrement orientée dans une seule direction, alors que sur le plan inconscient elle commence et finit en même temps dans l’Un cosmique, les cavaliers n’avancent pas dans l’indifférence réciproque, mais échangent continuellement appels, gestes, clins d’œil et informations de toutes sortes.

Mais alors, si les vivants placés dans ce que nous appelons communément « passé », « présent » et « futur », sont en réalité liés entre eux et font corps, inséparablement, avec une structure spatio-temporelle statique et unitaire, il s’ensuit que le passage de la faune de l’ère paléozoïque à la faune de l’ère mésozoïque — par exemple — ne peut plus être vu comme un événement de caractère simplement déterministe (la seconde faune étant causée, d’une manière ou d’une autre, par évolution darwinienne ou par macro-transformation discontinue, par la première exclusivement). Ce passage est aussi un événement de caractère finaliste. Cela revient à dire, en somme, que la faune de l’ère mésozoïque était ce qu’elle était, à cause tant de celle du paléozoïque que de celle des ères cénozoïque et actuelle, ainsi qu’à cause des ères futures structurant, avec les précédentes, l’architecture du chronotope. Le même discours doit être appliqué aux taxa biologiques. Une espèce fossile quelconque était ce qu’elle était, non seulement à cause d’une autre espèce particulière l’ayant précédée et dont elle aurait dérivé par évolution darwinienne ou par macro-transformation directe (la fameuse « espèce ancestrale »), mais aussi à cause de toutes les autres espèces plus ou moins proches qui l’avaient précédée et qui ensuite l’ont suivie dans le « temps intérieur », ou « structurel », ou « ontologique », du chrono-tope réel.

Il est donc inutile de s’efforcer de découvrir l’« ancêtre premier » d’un taxon quelconque. Dans une optique scientifique qui n’est plus grossièrement liée au déterminisme, mais qui est instruite par la relativité et la cybernétique, les « ancêtres » de chaque taxon biologique deviennent, comme chez Pirandello, « un, personne et cent mille » ! Et c’est alors qu’on finit par se rendre compte que tout problème relatif à la phylogenèse n’est autre, en réalité, qu’un faux problème.

Je voudrais vous comprendre mieux. Selon vous, par conséquent, dire par exemple que les oiseaux dérivent de formes comme Archaeopteryx ou, plus généralement, qu’ils ont été causés par des reptiles, n’aurait aucun sens ?

C’est cela. Et j’estime même qu’un autre problème n’a pas non plus de sens : celui qui consiste à se demander, mettons, si les mammifères ont été causés par des reptiles cynodontes du type Probainognathus ou du type Oligokyphus, ou si le chamois actuel a été produit par la miocène Pachygazella ou par le villafranchien Procamptoceras. À mon avis, et pour les raisons que je viens d’exposer, tout problème de caractère phylogénétique est en réalité un faux problème.

Peut-être voulez-vous dire que s’efforcer de construire des arbres généalogiques reliant des taxa qui ont vécu à des époques différentes, équivaut à une pure et simple perte de temps ?

C’est exactement ce que je veux dire. Et à ce sujet, le fait même d’avoir mentionné le chamois me rappelle mon ami Sandro Lovari, biologiste auteur d’un livre magnifique sur l’éco-éthologie [33]. Un jour, alors que nous étions à peine sortis de l’Institut de Géologie et Paléontologie de Florence (où Lovari avait voulu que je l’accompagne pour demander des renseignements sur, précisément, la paléontologie et la phylogenèse du chamois), je lui dis qu’à mon avis il était tout à fait inutile de se consacrer à des tentatives de reconstruction phylogénétique. Je me souviens qu’il me répondit : « Je n’ai pas l’impression que se demander le pourquoi de la présence d’un certain animal soit la même chose que disserter sur le sexe des anges ! ». Comme presque tous les biologistes, il était lui aussi tellement convaincu de ce qu’il disait qu’il me parut indélicat de le contredire. Mais le fait est que, plus les années passent, et plus je me convaincs que les deux problématiques reviennent au même et sont toutes deux sans valeur. Comme dit aussi Heitler, « l’histoire de la pensée est pleine de faux problèmes, dans la description desquels d’énormes quantités d’énergie intellectuelle et d’enthousiasme ont été dépensées. Parmi les exemples classiques de faux problèmes, il y eut celui relatif au nombre d’anges qui peuvent se tenir sur la pointe d’une aiguille, ou celui consacré à la capacité qu’aurait Dieu de créer un cercle avec trois angles. Mais souvent il est beaucoup plus difficile de reconnaître comme tels les faux problèmes, et parfois le progrès consiste précisément à découvrir qu’un problème donné est vide de sens. On pourrait citer comme exemples modernes de faux problèmes celui de la couleur d’un atome, ou celui relatif à la trajectoire parcourue dans un atome par un électron. Pour se rendre compte que ce dernier problème est un faux problème, il faut cependant déjà connaître toute la mécanique quantique » [34].

Chercher à interpréter de manière déterministe quelque chose comme le phénomène vivant, qui n’est pas du tout de nature exclusivement déterministe, revient à prétendre appliquer un certain type de logique à des choses qui n’obéissent pas à ce type de logique, ou qui n’y obéissent que partiellement. Ce serait comme se demander, par exemple, combien de cellulose est contenue dans le tronc d’une girafe, ou quelles fabriques de chaussures sont responsables de la production de sucre dans une région donnée. Des questions de ce genre seraient évidemment privées de sens, ce seraient précisément de faux problèmes qui, en tant que tels, pourraient fort bien être ignorés par notre pensée ; qui devraient même, à n’en pas douter, être ignorés, pour empêcher que dans d’autres domaines (philosophique, religieux, etc.), on ne procède de façon totalement erronée.

Connaissez-vous d’autres biologistes qui soient parvenus à des conclusions identiques ou proches des vôtres ?

Pour autant que je sache, le seul à s’être beaucoup rapproché de ma façon de voir a été le professeur Girolamo Azzi, l’auteur du traité d’Ecologia agraria aujourd’hui mondialement connu. Azzi était d’ailleurs très lié à Fantappié, puisqu’il avait participé, en 1943, avec celui-ci et quelques autres personnes (Ugo Spirito, E. Remotti, Francesco Carnelutti et Giuseppe Tucci), à la fondation du « Centre de Synthèse Scientifique ». Vingt ans plus tard, Azzi publia un ouvrage de biologie théorique [35], dans lequel il reconnaissait ouvertement l’insuffisance de l’évolutionnisme et proposait une « théorie du pointillage biologique » qui ne manquait pas d’heureuses intuitions, mais qui — à mon avis — péchait encore par approximation excessive. Cette théorie partait d’une « loi d’unité du complexe animal » qui, de façon fort significative, était très exactement énoncée comme suit : « Tous les animaux de la Terre, ceux qui furent et ceux qui seront, sont entre eux interdépendants et situés dans un ensemble ordonné et harmonieux ». Il est vraiment dommage que la mort prématurée de Fantappié et l’âge très avancé d’Azzi aient empêché de développer et d’affiner ces intuitions si éclairantes et si prometteuses.

_________________________________________

1 La science ne devrait se servir que de concepts définis de manière claire et univoque, et il faut reconnaître qu’en règle générale cette exigence a été admise et satisfaite. Mais la notion d’évolution a toujours constitué une exception bruyante et, probablement, non fortuite, à cette règle, puisqu’on a pu l’utiliser pour affirmer tout et le contraire de tout. Les philosophes modernes, tout en considérant l’idée d’évolution comme l’une des plus équivoques parmi celles en usage, et propre à recevoir les sens les plus vagues et même opposés, estiment cependant qu’elle doit correspondre à la définition qu’en a donnée Herbert Spencer, contemporain et admirateur de Darwin. « Il nous semble que la définition »transformation faisant passer un agrégat de l’homogène à l’hétérogène » (Spencer) » et qui « s’oppose à dissolution ou à involution, est celle qui correspond le mieux à l’esprit réel et historique de l’évolutionnisme et, par suite, nous pensons qu’il y aurait intérêt à ne prendre le mot évolution que dans cette acception précise » (A. Lalande, Vocabulaire technique et critique de la philosophie, 13ème éd., PUF, 1980, p. 312 et p. 314).

On doit toutefois faire observer que l’idée d’« agrégat homogène » ne correspondait pas, pour Spencer, à celle d’un ensemble de choses toutes égales entre elles, mais — au contraire —à un ensemble de choses très différentes entre elles, destinées sous l’effet du temps à se disjoindre, les unes et les autres ne se développant pas de manière égale (cf. A.C. Blanc, Cosmolisi interpretazione genetico-storica delle entità e degli aggruppamenti biologici ed etnologici, in Rivista di Antropologia, 34, 1942-43).

2 Cf. J.L. Jordanova, Lamarck, Oxford University Press, Oxford, 1984.

3 Jusqu’à il y a quelques années, Darwin était généralement considéré comme agnostique en matière religieuse. Mais depuis la publication de ses carnets M et N (1838-39) concernant l’homme, l’esprit et le matérialisme, on ne peut plus douter de son athéisme. Voir à ce sujet l’intéressant ouvrage de H.E. Gruber, Darwin on Man, Wildwood House, London, 1974.

4 La figure et l’œuvre de Georges Dagobert de Cuvier attendent encore d’être considérées à leur juste valeur. D’une manière générale, il est singulier et significatif que les paléontologues se soient habitués, jusqu’à maintenant, à ne voir en lui qu’un personnage secondaire, devant être placé plus bas que Darwin et Lamarck, et non pas le vrai père de leur discipline, ainsi que de l’anatomie comparée. Contrairement à ce qu’on entend dire souvent, Cuvier ne fut ni un ennemi dogmatique des idées nouvelles, ni un réactionnaire opportuniste et prisonnier de préjugés d’origine religieuse. Malheureusement, à partir du moment où certains lieux communs qui ne sont pas innocents se sont imposés, il devient extrêmement difficile de les déraciner.

5 Cf. Valerio Tonini, Le scelte della scienza, Studium, Roma, 1977.

6 Ludwig von Bertalanffy, Théorie générale des systèmes, Dunod, 2ème éd., 1980.

7 On entend par « conditions de contour » des valeurs numériques de certains paramètres ou propriétés d’invariance du système, déterminés en fonction de considérations extrinsèques ou de données de nature expérimentale.

8 Luigi Fantappié, Sui fondamenti gruppali della fisica, in Collectanea Mathematica, XI, 2, 1959, pp. 77-136.

9 Eliano Pessa, Teoria dei sistemi e modelli di Universo, in Responsabilità del Sapere, 29 (vol. 121-122), 1977, pp. 26-44.

10 Louis Bounoure, Déterminisme et finalité : double loi de la vie, Flammarion, 1957.

11 Walter Heitler, Der Mensch und die naturwissenschaftliche Erkenntnis, Vieweg u. Sohn, Braunschweig, 1962.

12 Orlando Gregorini, Biologia relativistica, Minarelli, Bologna, 1981. De notre point de vue, on ne peut pas soutenir que le holisme et le réductionnisme doivent exister de manière complémentaire, chacun des deux, à lui seul, ne suffisant pas à rendre compte des phénomènes vivants (cf. Olismo e riduzionismo, in Responsabilità del Sapere, 35, vol. 145-146, 1983). Le holisme (ou organicisme) et le réductionnisme représentent en effet deux philosophies bien distinctes. La première ne nie pas les phénomènes ni les causes reconnus par la seconde, mais les considère simplement comme partie intégrante d’une phénoménologie et d’une causalité plus amples et plus élevées. Au contraire, le réductionnisme ne prend en considération que certains phénomènes et certaines causes, niant qu’il puisse y en avoir d’autres ou s’en désintéressant.

13 Bernhard Dürken, Entwicklungsbiologie und Ganzheit, Leipzig-Berlin, 1936 (tr. it.: Biologia dello sviluppo e olismo, Sansoni, Firenze, 1943, pp. 133-134).

14 Mario Bunge, Causality, Harvard University Press, Cambridge (Mass.), 1963.

15 Voici ce que disait Galilée de la théorie copernicienne : « Je ne peux qu’admirer l’éminence de l’esprit de ceux qui l’ont reçue et estimée vraie, et ont par la vivacité de l’intellect fait violence telle à leurs sens qu’ils ont pu préférer ce que le discours leur dictait à ce que les expériences sensées leur montraient très ouvertement de contraire » (1632).

16 Cité par D. Zohar, Through the Time Barrier, Heinemann, London, 1982 (p. 141 de l’éd. it.).

17 Paul C.W. Davies, Spazio e tempo nell’universo moderno (trad. it. de Space and Time in the Modern Universe, Cambridge University Press, Cambridge, 1977), Laterza, Bari, 1980, p. 76.

18 Giuseppe Arcidiacono, Oltre la quarta dimensione, op. cit., pp. 17-18.

19 Cité par Fritjof Capra, Le Tao de la physique, op. cit., p. 189.

20 Hermann Weyl, Filosofia della matematica e delle scienze naturali (trad. it. de Philosophy of Mathematics and Natural Science, Princeton University Press, Princeton, 1949), Boring-hieri, Torino, 1967, p. 116.

21 Luigi Fantappié, Relatività e concetto di esistenza, in Giuseppe Arcidiacono, Relatività ed esistenza, op. cit., pp. 184-185.

22 Olivier Costa de Beauregard, Le Second Principe de la Science du Temps, Seuil, 1963, p. 125.

23 Olivier Costa de Beauregard, Op. cit., pp. 105-107.

24 Ibid., pp. 109-110.

25 Luigi Fantappié, Il finalismo originato dalle scienze esatte, in : F. Carnelutti, P. Rondoni et G. Bozzetti (ed.), Il valore del fine nel mondo, Centro Cultura e Civiltà Fondazione Cini, Sansoni, Firenze, 1955.

26 Olivier Costa de Beauregard, Op. cit., p. 113.

27 Galileo Galilei, Opere, edizione nationale, Barbera, Firenze, 1966, vol. IV, p. 22.