Traduction libre

16 juin 2024

« Faites confiance à la science ! »

C’est le mantra des tyrans technocratiques. Le cri de ralliement de la police orwellienne de la pensée. L’injonction des censeurs modernes qui cherchent à éliminer toute opposition du marché des idées.

Si vous lisez ces mots, vous le savez déjà. Ou vous devriez le savoir, puisque la raison pour laquelle j’ai été censuré de ThemTube [1] en 2021 était que j’avais osé produire un podcast sur la philosophie des sciences qui cherchait à interroger et à démanteler l’injonction « Faites confiance à la science ! »

Allons droit au but : en cette ère post-COVID, toute personne qui a la tête sur les épaules sait que « Faites confiance à la science ! » est une absurdité stupide, sans fondement, qui se réfute d’elle-même et qui est brandie par les autoritaires comme une massue contre la dissidence politique.

Mais aussi stupide que soit la phrase « Faites confiance à la science », elle est sur le point de devenir encore plus stupide.

Pourquoi ? Parce qu’une nouvelle est apparue le mois dernier, qui ébranle complètement la foi mal placée que le citoyen moyen, avaleur de propagande, entretenait encore à l’égard de la fiabilité de « la » science et le prétendu processus d’évaluation autocorrecteur par les pairs sur lequel repose « la » science.

Attachez vos ceintures, les amis. Cette histoire est dingue. Et elle laisse entrevoir un avenir si horriblement dystopique que même les voyous du « Faites confiance à la science » ne pourront pas le défendre.

LE VIEUX PROBLÈME

Vous souvenez-vous de l’« affaire Sokal » ?

Peut-être, ne connaissez-vous pas ce nom, mais je suis sûr que vous avez entendu l’histoire. En 1996, Alan Sokal, professeur de physique à l’université de New York et à l’University College London, était, selon ses propres termes, « troublé par un déclin apparent des normes de rigueur dans certains domaines des sciences humaines universitaires ». Plutôt que d’écrire un traité savant sur ses préoccupations, il a décidé de démontrer le problème d’une manière provocante (et hilarante) : en créant un canular dans une revue de sciences humaines évaluée par des pairs.

Sokal raconte :

Pour tester les normes intellectuelles en vigueur, j’ai donc décidé de tenter une expérience modeste (bien qu’incontrôlée, il faut le reconnaître) : Une importante revue nord-américaine d’études culturelles — dont le collectif éditorial comprend des sommités telles que Fredric Jameson et Andrew Ross — publierait-elle un article généreusement saupoudré d’absurdités si (a) il sonnait bien et (b) s’il flattait les préconceptions idéologiques des rédacteurs ?

Sans surprise, la réponse à cette question fut un « oui » catégorique.

Plus précisément, Sokal a écrit « Transgressing the Boundaries : Toward a Transformative Hermeneutics of Quantum Gravity » (Transgresser les frontières : Vers une herméneutique transformative de la gravitation quantique), une baliverne parfaitement incompréhensible qui cherche à déconstruire « la longue hégémonie post-Lumières sur les perspectives intellectuelles occidentales » en critiquant le langage même de la science — les mathématiques et la logique — et sa « contamination » par des forces « capitalistes, patriarcales et militaristes ».

« Ainsi, une science libératrice ne peut être complète sans une révision profonde du canon des mathématiques », conclut l’article satirique de Sokal, avant de concéder : « À ce jour, aucune mathématique émancipatrice n’existe, et nous ne pouvons que spéculer sur son contenu éventuel ».

En cours de route, il se lance dans une discussion impressionnante, mais totalement hors de propos sur des concepts ésotériques de la physique théorique, notamment « l’invariance de l’équation du champ d’Einstein sous l’effet de difféomorphismes non linéaires de l’espace-temps » et « la question de savoir si la théorie des cordes est la trame de l’espace-temps ou bien ce sont les champs morphogénétiques » qui apporteront finalement la réponse au « problème central non résolu de la physique théorique ».

Dans sa confession post-canular, « A Physicist Experiments With Cultural Studies », Sokal note qu’il a délibérément émaillé son article d’un charabia pseudoscientifique ridicule « afin que tout physicien ou mathématicien compétent (ou tout étudiant en physique ou en mathématiques) réalise qu’il s’agit d’une parodie ».

Alors, pourquoi l’article a-t-il passé le cap de l’examen par les pairs ? Selon Sokal :

Il est compréhensible que les éditeurs de Social Text aient été incapables d’évaluer de manière critique les aspects techniques de mon article (et c’est précisément la raison pour laquelle ils auraient dû consulter un scientifique). Ce qui est plus surprenant, c’est la facilité avec laquelle ils ont accepté mon implication que la recherche de la vérité en science doit être subordonnée à un agenda politique, et à quel point ils ont été inconscients de l’illogisme général de l’article.

En flattant l’ego des rédacteurs de Social Text en suggérant que la physique était trop importante pour être laissée aux scientifiques eux-mêmes et qu’elle devait être complétée par une théorie critique reflétant des idéologies féministes et anticapitalistes, l’article absurde a été, naturellement, accepté pour publication et dûment imprimé dans le numéro printemps/été 1996 de Social Text sur les « guerres des sciences ».

Malheureusement, ce canular n’a pas suffi à faire honte aux rédacteurs et aux évaluateurs des revues de sciences humaines pour qu’ils fassent un meilleur travail. Au contraire. Il a conduit, au cours des décennies suivantes, à la publication d’un certain nombre d’articles similaires (et de plus en plus ridicules).

Vous souvenez-vous de l’« affaire des études sur les griefs » ? Dans ce canular à la Sokal, qui s’est déroulé en 2017 et 2018, trois auteurs distincts — Peter Boghossian, James A. Lindsay et Helen Pluckrose — ont rédigé non pas un, mais vingt articles distincts pour démontrer que rien ne s’était amélioré depuis l’époque de la manœuvre originale de Sokal. Pire encore, le développement de la théorie sociale critique et de ce qu’on appelle les « études de griefs » avait en fait aggravé la situation au cours des deux décennies qui s’étaient écoulées.

Afin de pousser l’expérience à ses limites, le trio s’est assuré que « chaque article commençait par quelque chose d’absurde ou de profondément contraire à l’éthique (ou les deux) que nous voulions mettre en avant ou conclure ».

Voici quelques exemples d’articles qui n’ont pas seulement été soumis lors de cette incursion dans le monde universitaire incluent :

-

Human reactions to rape culture and queer performativity at urban dog parks in Portland, Oregon (Réactions humaines à la culture du viol et à la performativité queer dans les parcs à chiens urbains de Portland, Oregon), un article publié dans Gender, Place and Culture qui prétend aborder « des questions de géographie humaine et géographies de la sexualité », en observant le comportement des chiens et de leurs propriétaires dans les parcs à chiens afin de « déterminer quand une incidence de montures de chiens peut être qualifiée de viol » ;

-

When The Joke Is On You: A Feminist Perspective On How Positionality Influences Satire (Quand la blague est sur vous : Une perspective féministe sur l’influence de la position sur la satire), un article accepté pour publication par Hypatia, une revue de philosophie féministe de premier plan, qui soutient que les articles sur les canulars universitaires sont en fait une « forme sophistiquée, mais vide de réaction épistémique de préservation du privilège qui cherche à résoudre le malaise épistémique en imitant certaines idées de manière convaincante pour les offrir à la dérision d’autres personnes qui sont de manière similaire protectionniste sur le plan épistémique ».

-

Our Struggle Is My Struggle: Solidarity Feminism As An Intersectional Reply To Neoliberal and Choice Feminism (Notre lutte est ma lutte : Le féminisme solidaire comme réponse intersectionnelle au féminisme néolibéral et de choix), un article accepté pour publication par Affilia : Feminist Inquiry and Social Work qui, de l’aveu même des auteurs du canular, était « basé sur une réécriture d’environ 3 600 mots du chapitre 12 du volume 1 de Mein Kampf », et qui consistait à remplacer les invectives antijuives d’Hitler par les invectives antipatriarcales du fémi-nazi-sme moderne ; et

-

The conceptual penis as a social construct (Le pénis conceptuel en tant que construction sociale), publié dans Cogent Social Sciences, qui soutient… eh bien, je vous laisse découvrir par vous-même.

Bien entendu, tous ces articles ont été soit rétractés, soit rejetés pour publication… une fois que les mystificateurs ont admis le canular au Wall Street Journal. Ce n’est qu’après que le trio a avoué la vérité que les revues « respectées » et « évaluées par les pairs » — gardiennes de « la » science — ont réalisé qu’elles s’étaient fait avoir, ce qui a déclenché une tempête de publicité et une prise de conscience de la part du public quant à l’état des sciences sociales.

« Mais ACKSHUALLY (actuellement), injectent les défenseurs de La Science », les revues se sont toutes rétractées et ont désavoué les articles une fois que l’on a découvert qu’ils étaient frauduleux, ce qui montre bien que la science s’auto-corrige après tout, n’est-ce pas ? Et de toute façon, les auteurs de canulars ne font que révéler leur insécurité par rapport à leurs propres organes génitaux ! Faites confiance à La Science, les gars !

… Mais alors, pourquoi des articles absurdes comme Glaciers, gender, and science : A feminist glaciology framework for global environmental change research (Glaciers, genre et science : Un cadre de glaciologie féministe pour la recherche sur les changements environnementaux mondiaux)— un article publié dans Progress in Human Geography qui appelle à la construction d’une « glaciologie féministe » — continuent-ils d’être publiés ? (Pour ce que ça vaut, cet article n’était apparemment pas un canular… mais vous auriez pu me tromper !)

Ce que ces canulars ont démontré de manière spectaculaire, c’est un point qui est bien connu des universitaires travaillant au cœur de la fabrique de saucisses (connaissances) académiques depuis un certain temps : l’évaluation par les pairs n’est pas une garantie de valeur scientifique, malgré les assurances de la foule « Faites confiance à La Science ! »

Oui, les êtres humains normaux qui gagnent leur vie sur le marché libre en fournissant des produits ou des services utiles à leurs concitoyens savent depuis longtemps que tout ne va pas pour le mieux au pays de « la » science, où des chercheurs de plus en plus achetés et payés vivent en quémandant des subventions gouvernementales ou en se vendant au plus offrant des entreprises.

Mais — et je sais que vous allez avoir du mal à le croire — aussi grave que tout cela puisse paraître, cela pâlit en comparaison du nouveau problème qui est apparu le mois dernier.

LE NOUVEAU PROBLÈME

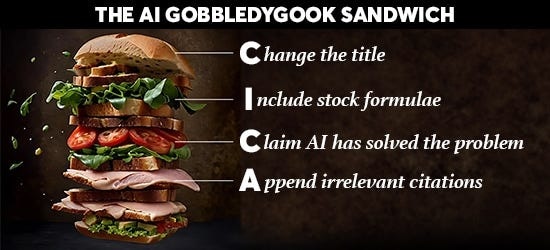

LE SANDWICH INDIGESTE DE l’IA

Modifier le titre ; Inclure des formules de stock ; Prétendre que l’IA a résolu le problème ; Ajouter des citations non pertinentes.

Bien sûr, des canulars générés par des humains et publiés par des revues académiques « respectables » constituent certainement le fond du baril lorsqu’il s’agit de « la science », n’est-ce pas ?

Non.

En 2005, une équipe de diplômés du MIT a créé « SCIgen – An Automatic CS Paper Generator », un programme qui « génère au hasard des articles de recherche en informatique, y compris des graphiques, des figures et des citations ».

Slate a fait un exposé sur le projet du MIT en 2014, dans lequel il résumait : « Grâce à SCIgen, depuis plusieurs années, du charabia écrit par ordinateur a été régulièrement publié dans des revues scientifiques et dans les actes de conférence ».

Ce qui devrait être doublement choquant pour ceux qui ont jusqu’à présent fait confiance aveuglement à « la » science, c’est qu’entre 2005 et l’exposé de Slate en 2014, des utilisateurs peu scrupuleux de SCIgen avaient déjà réussi à faire publier 120 de leurs articles de charabia générés par des algorithmes dans des revues académiques.

Ce remarquable exploit de tromperie a suscité de vives réactions de la part de la communauté scientifique et a poussé les communicateurs scientifiques à faire couler des litres d’encre (numérique) en rédigeant des articles d’introspection sur les erreurs commises par l’institution sacrée de l’évaluation par les pairs et sur la manière dont les universitaires peuvent collaborer pour redresser la barre et restaurer la confiance du public dans l’institution de la science.

Toutes ces réflexions moralisatrices ont-elles abouti à la fin de l’ère des articles de charabia ?

Non.

En fait, une étude réalisée en 2021 a révélé que 243 articles générés par SCIgen avaient été publiés par des revues académiques. Seuls 12 d’entre eux avaient été rétractés et 34 autres avaient été silencieusement supprimés. En d’autres termes, même des années après la révélation du problème, des centaines d’articles de charabia non rétractés encombraient encore les archives scientifiques.

Mais si un programme informatique vieux de près de vingt ans, destiné à générer des absurdités à consonance scientifique, semble un peu désuet à l’ère des grands modèles de langage dominée par ChatGPT, eh bien… vous avez raison ! C’est en effet le cas.

Oubliez les 243 faux articles générés par SCIgen. Le mois dernier, le Wall Street Journal a rapporté que Wiley, un pilier de l’industrie de l’édition scientifique vieux de 217 ans, rétractait plus de 11 300 articles frauduleux et fermait 19 revues.

Selon le rapport :

Au cours des deux dernières années, Wiley a rétracté plus de 11 300 articles qui semblaient compromis, selon un porte-parole, et a fermé quatre revues. Ce n’est pas le seul : Au moins deux autres éditeurs ont chacun retiré des centaines d’articles suspects. Plusieurs autres ont retiré de plus petits groupes d’articles douteux.

Bien que cette fraude à grande échelle ne représente qu’un faible pourcentage des soumissions aux revues, elle menace la légitimité de l’industrie de l’édition académique, qui pèse près de 30 milliards de dollars, et la crédibilité de la science dans son ensemble. (souligné par l’auteur).

Maintenant, le fait que l’édition universitaire soit une industrie de 30 milliards de dollars devrait être le premier indice du fait que « la » science n’est pas la poursuite impartiale de la vérité objective que les tyrans technocratiques veulent nous convaincre qu’elle est. Mais la façon dont cette industrie a été manipulée témoigne d’un degré de mépris pour la recherche scientifique qui est exaspérant même pour ceux qui sont déjà familiers avec La crise de la science.

Il faut préciser que ce n’était pas une escroquerie sophistiquée dans laquelle des bandes criminelles bien informées ont soigneusement mis au point un algorithme d’IA pour tromper habilement les évaluateurs universitaires. Au contraire, les exploitants de ces fausses usines à papier ont utilisé ce qu’un chercheur a baptisé « le sandwich indigeste de l’IA », un algorithme très simple permettant de transformer un article scientifique authentique en un morceau de charabia à consonance scientifique qui est (apparemment) suffisamment bon pour passer l’examen par les pairs.

Voici comment le sandwich est préparé.

Tout d’abord, un article scientifique authentique est volé et son titre est modifié pour relier le document à un sujet de recherche populaire. Ensuite, une section technique est concoctée à partir de formules courantes et de définitions standard. Ensuite, une section de résultats est ajoutée, prétendant montrer comment l’IA a été appliquée à un ensemble de données publiques afin de jeter un nouvel éclairage sur la question examinée. Enfin, quelques citations non pertinentes sont ajoutées pour donner au document une apparence de crédibilité académique.

Et voilà ! Le Sandwich indigeste est servi !

Ce qui est intéressant dans cette arnaque, ce n’est pas seulement qu’elle implique un algorithme informatique utilisant un Grand Modèle de Langage pour produire un charabia superficiellement convaincant, mais qu’elle s’appuie sur le prestige de la recherche en IA elle-même pour faire publier l’article. « Hé, les gars, l’IA a été utilisée pour s’attaquer à un problème d’une manière totalement nouvelle ! Regardez les résultats étonnants ».

L’histoire de ce scandale mérite d’être lue dans son intégralité, car elle soulève des questions intéressantes.

Tout d’abord, le fait qu’au moins 11 000 (!) de ces articles absurdes aient été publiés indique que l’ensemble du processus d’« examen par les pairs » est une farce.

Mais deuxièmement, cela confirme ce que toute personne ayant travaillé dans, autour ou à proximité du milieu académique sait depuis longtemps : de toute façon, personne ne lit ces revues. Aucun universitaire ne se soucie de la nouvelle étude publiée dans le Journal of East Mongolian Invertebrate Feminist Endicronology Studies Quarterly ou dans tout autre recoin obscur de cette industrie de l’édition qui pèse 30 milliards de dollars. Ces revues, et les documents bidons qui en remplissent les pages, n’existent que pour donner aux chercheurs un autre crédit de « publication évaluée par les pairs » pour leur CV académique.

Maintenant, au cas où vous penseriez que j’exagère le problème ou que vous soupçonnez que ces sandwichs indigestes d’articles générés par l’IA pourraient avoir une certaine valeur scientifique après tout, je vous invite à réfléchir à cette histoire :

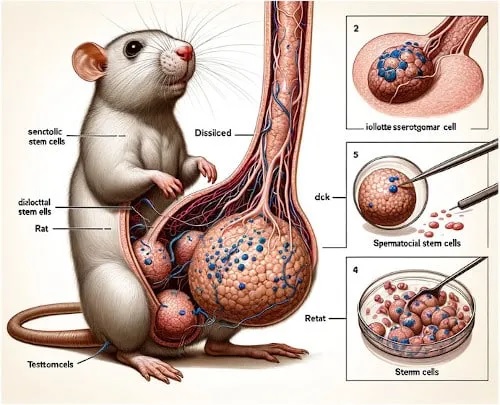

Un ridicule pénis de rat généré par IA a été publié dans une revue à comité de lecture.

N’hésitez pas à lire cet article et à découvrir tous les détails sordides de la façon dont « une revue scientifique de premier plan » a fini par publier « une image générée par l’IA d’un rat avec de gros organes génitaux, accompagnée d’une série de mots absurdes en charabia ». Mais en réalité, il suffit de regarder par soi-même, et de se rappeler que cela a été publié dans une revue scientifique de renom, soumise à un examen par les pairs !

On peut se demander : est-ce cela « la science » en laquelle nous sommes censés placer notre confiance. Quelqu’un peut-il appeler le Dr Fauci !

Mais bon, regardez le bon côté des choses : ça ne peut pas être pire que ça, n’est-ce pas ?

Je veux dire que nous avons certainement touché le fond de ce nadir académique, n’est-ce pas ?

Nous ne pouvons pas avoir encore moins de raisons de « faire confiance à La Science » à l’avenir, n’est-ce pas ?

LE NOUVEAU PROBLÈME EST ENCORE PIRE

Alors, vous pensez donc que des revues académiques « respectables » publiant des sandwichs indigestes d’articles générés par l’IA sont aussi mauvaises que possible ?

Eh bien, accrochez-vous, car je suis sur le point de vous surprendre : et si les « pairs évaluateurs » étaient eux-mêmes des IA ?

En fait, c’est une question piège. Il n’y a pas de « et si » ! L’IA est déjà utilisée pour « assister » dans le processus d’évaluation par les pairs.

Comme l’explique utilement un article de 2021 « AI-Assisted Peer Review », publié dans Humanities and Social Sciences Communications (une revue à comité de lecture en ligne et entièrement en libre accès publiée par Nature Portfolio) :

Le processus de communication savante est mis à rude épreuve, notamment en raison de l’augmentation des demandes adressées aux évaluateurs par les pairs et de leur temps. Les soumissions de manuscrits aux revues à comité de lecture ont connu une croissance annuelle sans précédent de 6,1 % depuis 2013 et une augmentation considérable des taux de rétractation (Publons, 2018). On estime que plus de 15 millions d’heures sont consacrées chaque année à l’examen de manuscrits précédemment rejetés, puis soumis à nouveau à d’autres revues.

Oh, non ! Qui pensera aux enfants… euh, aux évaluateurs par les pairs !

Heureusement, les technocrates de l’IA sont là pour nous aider :

Les développements qui peuvent rendre plus efficace le processus de contrôle/assurance de la qualité associé aux résultats de la recherche, en particulier le processus d’évaluation par les pairs, sont susceptibles d’être accueillis favorablement par la communauté des chercheurs. Il existe déjà un certain nombre d’initiatives faisant appel à des outils de filtrage automatisés dans des domaines tels que la prévention du plagiat, les contrôles de conformité aux exigences, ainsi que l’appariement et la notation des manuscrits entre les évaluateurs. Nombre de ces outils font appel à l’intelligence artificielle (IA), à l’apprentissage automatique et au traitement du langage naturel de grands ensembles de données.

C’est exact, mesdames et messieurs. Afin d’aider les pairs évaluateurs qui souffrent du déluge d’articles (pour la plupart générés par l’IA) à évaluer, ils se tournent vers…. L’IA ! Qu’est-ce qui pourrait mal tourner ?

Il est important de comprendre qu’il ne s’agit pas d’une idée marginale. Bien au contraire. En fait, l’idée de l’évaluation par les pairs assistée par l’IA semble être l’un des sujets les plus brûlants dans les périodiques évalués par les pairs ces jours-ci, avec des articles dans Nature et le Journal of Medical Research, Learned Publishing, Springer Nature, ACS Energy Letters et de nombreuses autres revues qui ont abordé le sujet ces dernières années.

Étant donné la rapidité avec laquelle l’idée d’une évaluation par les pairs assistée par l’IA (ou même pilotée par l’IA et « assistée » par l’homme) a été normalisée dans le monde universitaire, il est possible de ne pas voir à quel point cet état de fait est absolument délirant.

Pour bien comprendre cette folie, je vous suggère de lire « How generative AI will ruin science and academic research (Comment l’IA générative va ruiner la science et la recherche universitaire) », un article récent sur le sujet sur ce site qui approfondit les ramifications philosophiques de ce développement.

Comme le note l’auteur de cet article :

L’IA examinera les articles rédigés par des algorithmes et publiés dans des revues qui ne seront lues par personne. Sauf peut-être par l’IA elle-même, qui génère désormais ses propres données d’entraînement dans une boucle de rétroaction informationnelle maléfique qui sera remplie d’hallucinations structurellement intégrées.

Où est donc le contrôle de la qualité ? Comment est-ce concevable ? Qui se chargera de la « vérification des faits » des torrents d’informations générées par l’IA ? Et en référence à quelles données ? Des articles de recherche générés ou rédigés par l’IA, dont les informations ont été déconnectées de la fiabilité, de l’objectivité et de la validité, et qui sont maintenant produits dans le but de renforcer le comportement rentable des consommateurs et la formation stratégique de l’opinion ?

Oui, l’ouroboros de l’IA est maintenant prêt à commencer à manger sa propre queue.

Bientôt, il est concevable qu’une partie importante de l’industrie de l’édition universitaire, qui pèse 30 milliards de dollars par an, soit constituée d’« IA » (c’est-à-dire de grands modèles de langage) générant des articles de charabia qui seront examinés par d’autres « IA » (LLM) ayant été formés sur du contenu de charabia généré par l’« IA » (LLM).

Comme on dit : des données pourries, des résultats pourris.

LA SOLUTION

Comme je l’ai écrit plus haut, si les particularités de ce dilemme généré par l’IA peuvent être nouvelles, il n’y a rien de nouveau dans l’idée que « publier ou périr » de l’entreprise universitaire moderne pervertit fondamentalement nos méthodes institutionnelles de production de connaissances. En fait, tout cela devrait être très familier à ceux qui ont assisté à ma présentation sur la crise de la science.

Comme d’habitude, il est important de connaître le problème, mais seulement dans la mesure où cette connaissance peut nous orienter vers la solution à ce problème. Comme vous le savez certainement, c’est la raison pour laquelle j’ai fait suivre mon podcast sur la crise de la science d’un podcast sur les solutions : La science ouverte.

En bref : oui, il y a une solution à ce désordre, mais elle ne viendra pas du fait de compter sur l’IA pour résoudre le problème que l’IA est en train de créer.

Et ce n’est pas en « faisant confiance à la science » qu’on y parviendra.

Cela viendra d’une approche fondamentalement différente, décentralisée en open source, de l’acquisition des connaissances et d’une critique par les pairs horizontale et décentralisée qui enlèvera la conversation des mains de l’industrie de l’édition universitaire achetée et payée pour la remettre entre les mains des chercheurs et des profanes intéressés.

La bonne nouvelle est que cette conversation a déjà lieu, mais qu’elle n’est pas annoncée par les technocrates et leurs sous-fifres scientifiques, leurs revues universitaires contrôlées par l’IA et la presse scientifique officielle. Et maintenant que vous êtes au courant, vous faites vous aussi partie de la solution !

Faites passer le mot : « Faites confiance à la science » est mort. Les jeunes branchés disent maintenant « Devenez la science ».

Texte original : https://corbettreport.substack.com/p/trust-the-computer-generated-gobbledygook

___________

1 NDT LeurTube pour dire YouTube.